Udviklingen af AI-modelarkitekturer og banebrydende teknologier

Mere effektive arkitekturmodeller

Fremtiden for samtale-AI er uløseligt forbundet med udviklingen af AI-modelarkitekturer, som gennemgår en hurtig transformation mod højere effektivitet og ydeevne. Et centralt aspekt af denne udvikling er teknologien Mixture-of-Experts (MoE), som repræsenterer et markant skift fra monolitiske modeller til en modulær tilgang. Denne arkitektur opdeler det neurale netværk i specialiserede "eksperter", som kun aktiveres for specifikke inputtyper, hvilket dramatisk øger beregningseffektiviteten.

En parallel tendens er implementeringen af mekanismer sparse activation, som muliggør selektiv aktivering af kun relevante dele af modellen til en specifik opgave. I modsætning til traditionelle arkitekturer, hvor alle neuroner aktiveres, reducerer sparse activation dramatisk beregningskravene og muliggør konstruktion af betydeligt større modeller, samtidig med at en effektiv inferenstid opretholdes. Den praktiske konsekvens af disse innovationer er muligheden for at implementere mere sofistikerede AI-chatbots selv på edge-enheder med begrænset beregningskapacitet.

Specialiserede modulære arkitekturer

En anden udviklingsretning er specialiserede modulære arkitekturer, der kombinerer generiske komponenter med domænespecifikke moduler. Disse systemer integrerer fortrænede generiske grundlag med snævert specialiserede moduler til specifikke domæner som medicin, jura eller finans, hvilket gør det muligt at opnå et ekspertniveau af viden og evner uden at skulle træne hele modellen fra bunden. Denne tilgang reducerer udviklingsomkostningerne betydeligt og øger samtidig nøjagtigheden og relevansen af svar inden for specifikke områder.

Udvidelse af kontekstuel forståelse

Udviklingen af AI-modelarkitekturer bevæger sig mod en radikal udvidelse af kontekstvinduet, hvilket repræsenterer et fundamentalt skift i evnen til at behandle og reagere kohærent på komplekse input. De nuværende begrænsninger på titusinder eller hundredtusinder af tokens vil blive overvundet i de kommende generationer af modeller, mod millioner af tokens eller potentielt en praktisk talt ubegrænset kontekst. Denne udvidelse vil gøre det muligt for samtalesystemer at opretholde konsistente langsigtede interaktioner og behandle omfattende dokumenter som komplette bøger, forskningsartikler eller tekniske manualer i en enkelt gennemgang.

Teknologiske drivkræfter for denne transformation inkluderer hierarkisk kontekstbehandling, hvor modellen opererer med repræsentationer på flere niveauer - fra et detaljeret lokalt niveau til globale abstraktioner. En anden innovativ tilgang er rekursiv opsummering, hvor systemet løbende komprimerer historisk information til tætte repræsentationer, der bevarer nøgleinformation, samtidig med at hukommelseskravene minimeres. En ny teknik er også attention caching, som optimerer gentagne beregninger på overlappende dele af konteksten.

Dynamisk kontekststyring

Avancerede arkitekturer implementerer dynamisk kontekststyring, som intelligent prioriterer og udvælger relevant information baseret på dens vigtighed for den aktuelle samtale. Denne tilgang kombinerer strategier som informationssøgning, lokal cache og lagring af langtidshukommelse for effektivt at arbejde med praktisk talt ubegrænsede mængder kontekstuel information. Den praktiske effekt af disse innovationer er AI-assistenters evne til at levere konsistente, kontekstuelt relevante svar selv inden for komplekse multi-session interaktioner, der strækker sig over længere tidshorisonter.

Avancerede kognitive evner

En grundlæggende tendens i udviklingen af AI-arkitekturer er skiftet fra rent reaktive systemer til modeller med avancerede kognitive evner, som kvalitativt transformerer deres anvendelighed til løsning af komplekse problemer. Den nye generation af samtalesystemer demonstrerer markant mere sofistikeret kausal ræsonnement - evnen til at identificere årsagssammenhænge, skelne mellem korrelation og kausalitet og konstruere robuste mentale modeller af problemdomæner. Denne evne gør det muligt for AI-chatbots at levere dybere analyser, mere præcise forudsigelser og mere værdifulde datafortolkninger sammenlignet med tidligere generationer.

En parallel udviklingsretning er fremskridt inden for abstrakt og analog tænkning, hvor modeller kan identificere mønstre på højt niveau og anvende koncepter fra et domæne på problemer i et andet. Denne evne er afgørende for kreativ problemløsning, tværfaglig vidensoverførsel og identifikation af ikke-indlysende forbindelser, som ofte repræsenterer den højeste værdi i kompleks beslutningstagning. En vigtig dimension er også udviklingen af metakognitive evner - modellens evne til at reflektere over sine egne tankeprocesser, evaluere kvaliteten af sine svar og identificere grænserne for sin egen viden.

Algoritmisk ræsonnement og problemløsning i flere trin

Avancerede arkitekturer demonstrerer markante fremskridt inden for algoritmisk ræsonnement og problemløsning i flere trin - evnen til at nedbryde komplekse problemer i en række deltrin, systematisk løse dem og integrere delresultater i en sammenhængende løsning. Denne evne er essentiel for opgaver, der kræver en struktureret tilgang, såsom matematiske udledninger, kompleks planlægning eller fejlfinding i komplekse systemer. Kombineret med øget præcision (evnen til at minimere hallucinationer og faktuelle fejl) transformerer disse avancerede kognitive kapaciteter AI-chats fra primært kommunikationsværktøjer til sofistikerede kognitive assistenter, der er i stand til at yde substantiel støtte til løsning af reelle problemer.

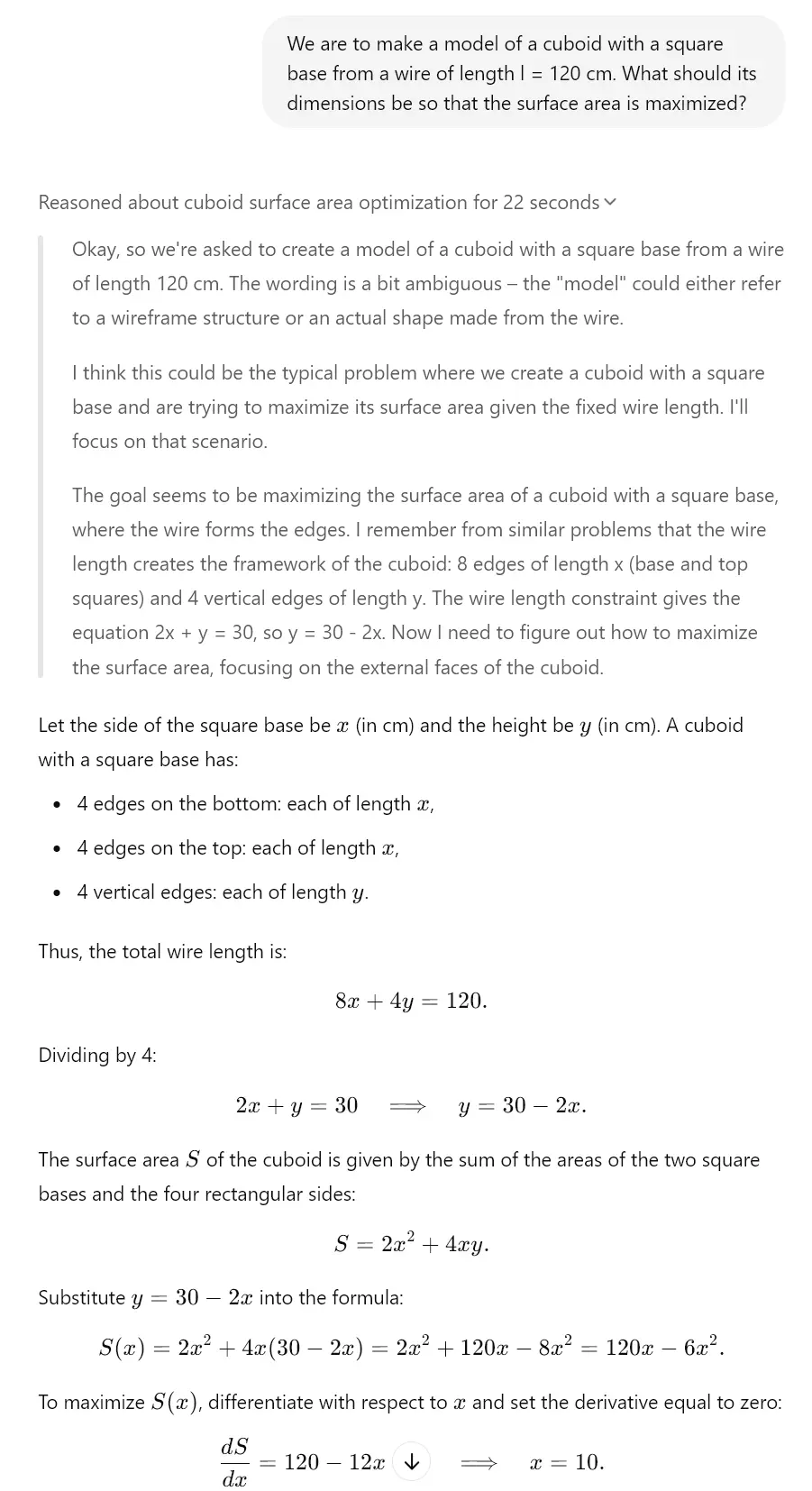

Dette ses i sidste ende allerede i dag hos "tænkende" modeller. F.eks. har Gemini 2.0, Claude 3.7 Sonnet eller ChatGPT o1 disse funktioner. Se eksemplet, vi har skabt til dig ved hjælp af o3-mini-modellen, som har en lignende tænkende mekanisme.

Optimering af parametre og output

Et kritisk aspekt af udviklingen af AI-arkitekturer er den kontinuerlige optimering af parametre og output, som øger effektiviteten og kvaliteten af det genererede indhold. Kvantiseringsteknikker repræsenterer et markant fremskridt inden for modelkomprimering og metoder til reduktion af hukommelses- og beregningskrav, samtidig med at størstedelen af den oprindelige ydeevne bevares. Moderne tilgange som post-training kvantisering og inferens med blandet præcision gør det muligt at reducere modelstørrelsen med op til 75% med minimal forringelse af ydeevnen, hvilket dramatisk udvider spektret af enheder, der er i stand til at hoste sofistikerede samtale-AI-systemer.

En parallel tendens er optimering gennem knowledge distillation, hvor viden fra store "lærer"-modeller overføres til mere kompakte "elev"-modeller. Denne proces komprimerer effektivt information fanget i komplekse neurale netværk til mindre arkitekturer, der kan implementeres i miljøer med begrænsede ressourcer. Et betydeligt potentiale ligger også i hardwarespecifikke optimeringer, hvor modelarkitekturen er specifikt tilpasset for maksimal ydeevne på specifik hardware (CPU, GPU, TPU, neuromorfe chips), hvilket gør det muligt at opnå markant højere inferenshastighed.

Adaptive output-mekanismer

Avancerede arkitekturer implementerer adaptive output-mekanismer, som dynamisk tilpasser genereringen af svar baseret på kontekst, krav til nøjagtighed og tilgængelige beregningsressourcer. Disse systemer balancerer intelligent mellem kvalitet, hastighed og effektivitet gennem teknikker som inferens med tidlig afslutning og progressiv rendering. Den praktiske konsekvens af disse optimeringer er evnen til at implementere højt sofistikerede AI-assistenter selv i edge computing-scenarier som mobilitet, IoT-enheder eller bærbare enheder til augmented reality, hvor traditionelle store sprogmodeller er ubrugelige på grund af ressourcebegrænsninger.

Neuronal netværk og deres udvikling

Et fundamentalt aspekt af udviklingen af AI-modeller er innovation inden for arkitekturen af neurale netværk, som definerer deres evner og begrænsninger. Transformativt potentiale har hybridarkitekturer, der kombinerer forskellige typer neurale netværk for at maksimere deres styrker. Disse systemer integrerer transformer-baserede modeller optimeret til tekstforståelse med konvolutionelle netværk til visuel analyse, rekurrent netværk til sekventielle data og grafneurale netværk til struktureret information, hvilket muliggør skabelsen af alsidige systemer, der kan operere på tværs af forskellige domæner og datatyper.

En anden udviklingsretning er rekurrent transformere, som adresserer begrænsningerne i standard transformer-arkitekturer inden for sekventiel behandling og temporal ræsonnement. Disse modeller implementerer rekurrent mekanismer som tilstandssporing og iterativ forfining, hvilket markant forbedrer deres evne til at modellere dynamiske processer, trinvis ræsonnement og komplekse sekventielle afhængigheder. Denne evne er essentiel for opgaver som simulering, strategisk planlægning eller langsigtede forudsigelser, der kræver en sofistikeret forståelse af temporale relationer.

Selvmodificerende og selvforbedrende arkitekturer

En ny tendens er selvmodificerende og selvforbedrende arkitekturer, som kan tilpasse deres struktur og parametre som reaktion på specifikke opgaver. Disse systemer implementerer meta-læringsmekanismer, der kontinuerligt optimerer deres interne konfiguration baseret på feedback-loops og ydelsesmålinger. En nøgledimension er også Neural Architecture Search (NAS), hvor AI-systemer automatisk designer og optimerer nye neurale netværksarkitekturer, der er specifikt tilpasset konkrete anvendelsestilfælde. Denne tilgang accelererer iterationen af AI-modeller og muliggør skabelsen af højeffektive brugerdefinerede arkitekturer til specifikke anvendelsesdomæner for samtale-AI.

Evolutionens indflydelse på samtale-AI

Den samlede indflydelse af udviklingen af AI-arkitekturer på samtalesystemer er transformativ og medfører et fundamentalt skift i deres evner og anvendelsespotentiale. Multimodal integration er et nøgleelement i denne transformation - moderne arkitekturer muliggør en flydende overgang mellem tekst, billede, lyd og andre modaliteter, hvilket udvider samtaleinterfaces ud over ren tekstinteraktion. Denne integration gør det muligt for AI-chatbots at analysere visuelle input, reagere på multimedieindhold og generere svar med rige medier, der kombinerer tekst med visuelle eller auditive elementer. For et mere detaljeret kig på dette emne kan du se analysen af autonome AI-agenter og multimodale systemer.

Et parallelt aspekt er kontinuerlig læring i realtid, hvor avancerede arkitekturer løbende kan opdatere deres viden og tilpasse sig ny information uden behov for komplet genoptræning. Denne tilgang adresserer en central begrænsning ved traditionelle statiske modeller - den hurtige forældelse af viden i dynamisk udviklende domæner. En ny arkitektonisk tilgang er også lokal finjustering, som optimerer modellens ydeevne til en specifik kontekst eller bruger, samtidig med at de generiske evner i grundmodellen bevares.

Ny generation af samtaleassistenter

Den kumulative effekt af disse arkitektoniske innovationer er fremkomsten af en ny generation af samtaleassistenter med kvalitativt forskellige evner. Disse systemer overskrider paradigmet med reaktive værktøjer til spørgsmål og svar og bevæger sig mod proaktive kognitive partnere, der er i stand til selvstændig ræsonnement, kontinuerlig læring og tilpasning til specifikke brugerbehov. Praktiske anvendelser inkluderer personaliserede uddannelsessystemer, der dynamisk tilpasser indhold og pædagogisk tilgang til den studerendes læringsstil; forskningsassistenter, der er i stand til at formulere hypoteser og foreslå eksperimentelt design; eller strategiske rådgivere, der yder substantiel støtte til kompleks beslutningstagning i en forretningskontekst. Denne udvikling repræsenterer et markant skift mod AI-systemer, der fungerer som ægte kognitive forstærkere, der eksponentielt udvider menneskelige kognitive kapaciteter.