Evolution der KI-Modellarchitekturen und bahnbrechende Technologien

Effizientere Architekturmodelle

Die Zukunft der konversationellen künstlichen Intelligenz ist untrennbar mit der Evolution der KI-Modellarchitekturen verbunden, die eine rapide Transformation hin zu höherer Effizienz und Leistung durchlaufen. Ein Schlüsselaspekt dieser Evolution ist die Technologie Mixture-of-Experts (MoE), die einen bedeutenden Wandel von monolithischen Modellen zu einem modularen Ansatz darstellt. Diese Architektur teilt das neuronale Netz in spezialisierte „Experten“ auf, die nur für spezifische Eingabetypen aktiviert werden, was die Effizienz der Berechnungen dramatisch erhöht.

Ein paralleler Trend ist die Implementierung von Mechanismen der Sparse Activation, die eine selektive Aktivierung nur relevanter Teile des Modells für eine bestimmte Aufgabe ermöglichen. Im Gegensatz zu traditionellen Architekturen, bei denen alle Neuronen aktiviert werden, reduziert Sparse Activation den Rechenaufwand drastisch und ermöglicht die Konstruktion deutlich größerer Modelle bei gleichzeitig effizienter Inferenzzeit. Die praktische Konsequenz dieser Innovationen ist die Möglichkeit, anspruchsvollere KI-Chatbots auch auf Edge-Geräten mit begrenzten Rechenkapazitäten einzusetzen.

Spezialisierte modulare Architekturen

Eine weitere Entwicklungsrichtung stellen spezialisierte modulare Architekturen dar, die generische Komponenten mit domänenspezifischen Modulen kombinieren. Diese Systeme integrieren vortrainierte generische Grundlagen mit eng spezialisierten Modulen für spezifische Domänen wie Medizin, Recht oder Finanzen, was es ermöglicht, Expertenwissen und -fähigkeiten zu erreichen, ohne das gesamte Modell von Grund auf trainieren zu müssen. Dieser Ansatz reduziert die Entwicklungskosten signifikant und erhöht gleichzeitig die Genauigkeit und Relevanz der Antworten in spezifischen Bereichen.

Erweiterung des Kontextverständnisses

Die Evolution der KI-Modellarchitektur zielt auf eine radikale Erweiterung des Kontextfensters ab, was einen fundamentalen Wandel in der Fähigkeit darstellt, komplexe Eingaben zu verarbeiten und kohärent darauf zu reagieren. Die derzeitigen Beschränkungen im Bereich von Zehn- oder Hunderttausenden von Tokens werden in den kommenden Modellgenerationen in Richtung Millionen von Tokens oder potenziell praktisch unbegrenztem Kontext überwunden werden. Diese Erweiterung wird es Konversationssystemen ermöglichen, konsistente Langzeitinteraktionen aufrechtzuerhalten und umfangreiche Dokumente wie komplette Bücher, Forschungsarbeiten oder technische Handbücher in einem einzigen Durchgang zu verarbeiten.

Technologische Wegbereiter dieser Transformation umfassen die hierarchische Kontextverarbeitung, bei der das Modell mit mehrstufigen Repräsentationen operiert – von der detaillierten lokalen Ebene bis hin zu globalen Abstraktionen. Ein weiterer innovativer Ansatz ist die rekursive Zusammenfassung, bei der das System historische Informationen kontinuierlich in dichte Repräsentationen komprimiert, die Schlüsselinformationen bei minimalem Speicherbedarf bewahren. Eine aufkommende Technik ist auch das Attention Caching, das wiederholte Berechnungen an überlappenden Teilen des Kontexts optimiert.

Dynamische Kontextsteuerung

Fortgeschrittene Architekturen implementieren eine dynamische Kontextsteuerung, die relevante Informationen intelligent priorisiert und basierend auf ihrer Bedeutung für die aktuelle Konversation auswählt. Dieser Ansatz kombiniert Strategien wie Informationssuche, lokalen Cache und Langzeitgedächtnisspeicherung für eine effiziente Arbeit mit praktisch unbegrenzten Mengen an kontextuellen Informationen. Die praktische Auswirkung dieser Innovationen ist die Fähigkeit von KI-Assistenten, konsistente, kontextuell relevante Antworten auch im Rahmen komplexer, über längere Zeiträume stattfindender Multi-Session-Interaktionen zu liefern.

Fortgeschrittene kognitive Fähigkeiten

Ein wesentlicher Trend in der Evolution der KI-Architekturen ist der Wandel von rein reaktiven Systemen zu Modellen mit fortgeschrittenen kognitiven Fähigkeiten, die ihre Nützlichkeit bei der Lösung komplexer Probleme qualitativ verändern. Die neue Generation von Konversationssystemen demonstriert ein deutlich anspruchsvolleres kausales Denken – die Fähigkeit, kausale Beziehungen zu identifizieren, Korrelation von Kausalität zu unterscheiden und robuste mentale Modelle von Problemdomänen zu konstruieren. Diese Fähigkeit ermöglicht es KI-Chatbots, tiefere Analysen, präzisere Vorhersagen und wertvollere Dateninterpretationen im Vergleich zu früheren Generationen zu liefern.

Ein paralleler Entwicklungspfad ist der Fortschritt im abstrakten und analogen Denken, bei dem Modelle in der Lage sind, hochrangige Muster zu identifizieren und Konzepte aus einer Domäne auf Probleme in einer anderen Domäne anzuwenden. Diese Fähigkeit ist entscheidend für kreative Problemlösungen, interdisziplinären Wissenstransfer und die Identifizierung nicht offensichtlicher Zusammenhänge, die oft den höchsten Wert bei komplexen Entscheidungen darstellen. Eine wichtige Dimension stellt auch die Entwicklung meta-kognitiver Fähigkeiten dar – die Fähigkeit des Modells, seine eigenen Denkprozesse zu reflektieren, die Qualität seiner Antworten zu bewerten und die Grenzen seines eigenen Wissens zu identifizieren.

Algorithmisches Denken und mehrstufige Problemlösung

Fortgeschrittene Architekturen zeigen einen deutlichen Fortschritt im algorithmischen Denken und der mehrstufigen Problemlösung – der Fähigkeit, komplexe Probleme in eine Reihe von Teilschritten zu zerlegen, diese systematisch zu lösen und Teilergebnisse zu einer kohärenten Lösung zu integrieren. Diese Fähigkeit ist essentiell für Aufgaben, die einen strukturierten Ansatz erfordern, wie mathematische Ableitungen, komplexe Planung oder das Debuggen komplexer Systeme. In Kombination mit erhöhter Genauigkeit (der Fähigkeit, Halluzinationen und sachliche Fehler zu minimieren) transformieren diese fortgeschrittenen kognitiven Kapazitäten KI-Chats von primär Kommunikationswerkzeugen zu anspruchsvollen kognitiven Assistenten, die in der Lage sind, substantielle Unterstützung bei der Lösung realer Probleme zu leisten.

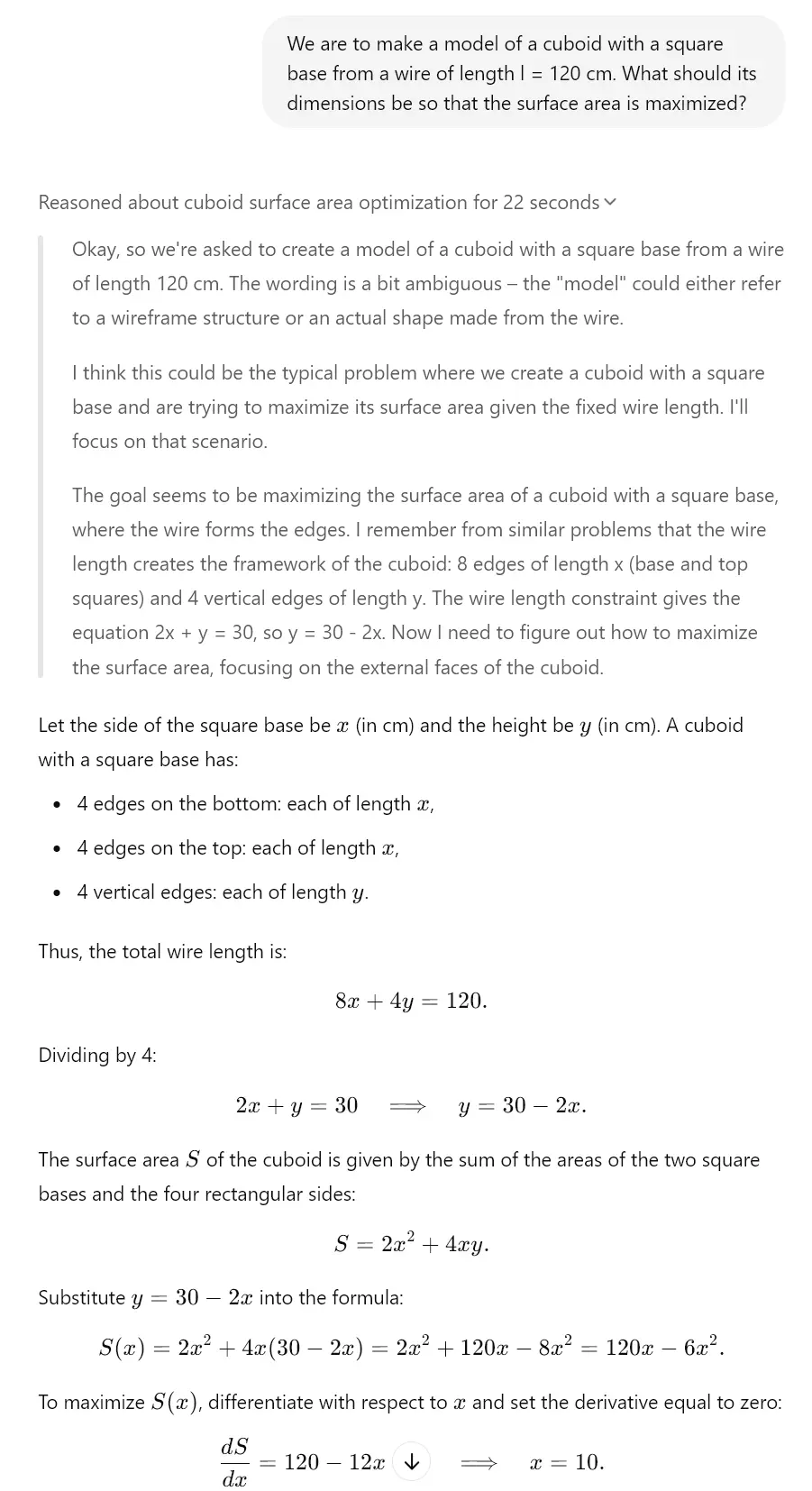

Dies zeigt sich letztendlich bereits heute bei „denkenden“ Modellen. Zum Beispiel verfügen Gemini 2.0, Claude 3.7 Sonnet oder ChatGPT o1 über diese Funktionen. Sehen Sie sich das Beispiel an, das wir dank des Modells o3-mini für Sie erstellt haben, das einen ähnlichen Denkmechanismus aufweist.

Optimierung von Parametern und Ausgaben

Ein kritischer Aspekt der Evolution von KI-Architekturen ist die kontinuierliche Optimierung von Parametern und Ausgaben, die die Effizienz und Qualität der generierten Inhalte erhöht. Quantisierungstechniken stellen einen bedeutenden Fortschritt bei der Komprimierung von Modellen dar und repräsentieren Methoden zur Reduzierung des Speicher- und Rechenaufwands bei gleichzeitiger Beibehaltung des Großteils der ursprünglichen Leistung. Moderne Ansätze wie Post-Training-Quantisierung und Inferenz mit gemischter Präzision ermöglichen es, die Größe von Modellen um bis zu 75 % bei minimaler Leistungsverschlechterung zu reduzieren, was das Spektrum der Geräte, die anspruchsvolle konversationelle KI-Systeme hosten können, dramatisch erweitert.

Ein paralleler Trend ist die Optimierung durch Wissensdestillation, bei der Wissen aus großen „Lehrer“-Modellen in kompaktere „Schüler“-Modelle übertragen wird. Dieser Prozess komprimiert effektiv Informationen, die in komplexen neuronalen Netzen erfasst wurden, in kleinere Architekturen, die in Umgebungen mit begrenzten Ressourcen eingesetzt werden können. Ein signifikantes Potenzial stellen auch hardware-spezifische Optimierungen dar, bei denen die Modellarchitektur spezifisch für maximale Leistung auf bestimmter Hardware (CPU, GPU, TPU, neuromorphe Chips) angepasst wird, was es ermöglicht, deutlich höhere Inferenzgeschwindigkeiten zu erreichen.

Adaptive Ausgabemechanismen

Fortgeschrittene Architekturen implementieren adaptive Ausgabemechanismen, die die Generierung von Antworten dynamisch an den Kontext, die Genauigkeitsanforderungen und die verfügbaren Rechenressourcen anpassen. Diese Systeme balancieren intelligent zwischen Qualität, Geschwindigkeit und Effizienz durch Techniken wie Inferenz mit frühem Abbruch und progressives Rendering. Die praktische Konsequenz dieser Optimierungen ist die Fähigkeit, hochentwickelte KI-Assistenten auch in Edge-Computing-Szenarien wie Mobilität, IoT-Geräten oder tragbaren Geräten für erweiterte Realität einzusetzen, wo traditionelle große Sprachmodelle aufgrund von Ressourcenbeschränkungen unbrauchbar sind.

Neuronale Netze und ihre Entwicklung

Ein fundamentaler Aspekt der Evolution von KI-Modellen ist die Innovation in der Architektur neuronaler Netze, die ihre Fähigkeiten und Grenzen definiert. Ein transformatives Potenzial haben hybride Architekturen, die verschiedene Typen neuronaler Netze kombinieren, um deren Stärken zu maximieren. Diese Systeme integrieren auf Transformern basierende Modelle, die für das Textverständnis optimiert sind, mit Convolutional Neural Networks für die visuelle Analyse, rekurrenten Netzen für sequentielle Daten und Graph Neural Networks für strukturierte Informationen, was die Schaffung vielseitiger Systeme ermöglicht, die über verschiedene Domänen und Datentypen hinweg operieren können.

Eine weitere Entwicklungsrichtung stellen rekurrente Transformer dar, die die Beschränkungen von Standard-Transformer-Architekturen im Bereich der sequentiellen Verarbeitung und des temporalen Denkens adressieren. Diese Modelle implementieren rekurrente Mechanismen wie Zustandsverfolgung und iterative Verfeinerung, was ihre Fähigkeit zur Modellierung dynamischer Prozesse, schrittweisen Denkens und komplexer sequentieller Abhängigkeiten signifikant verbessert. Diese Fähigkeit ist essentiell für Aufgaben wie Simulation, strategische Planung oder langfristige Vorhersagen, die ein anspruchsvolles Verständnis temporaler Beziehungen erfordern.

Selbstmodifizierende und selbstverbessernde Architekturen

Ein aufkommender Trend sind selbstmodifizierende und selbstverbessernde Architekturen, die ihre Struktur und Parameter als Reaktion auf spezifische Aufgaben anpassen können. Diese Systeme implementieren Meta-Lernmechanismen, die ihre interne Konfiguration kontinuierlich auf der Grundlage von Feedbackschleifen und Leistungsmetriken optimieren. Eine Schlüsseldimension stellt auch die Suche nach neuronalen Architekturen (NAS) dar, bei der KI-Systeme automatisch neue Architekturen neuronaler Netze entwerfen und optimieren, die speziell auf konkrete Anwendungsfälle zugeschnitten sind. Dieser Ansatz beschleunigt die Iteration von KI-Modellen und ermöglicht die Schaffung hocheffizienter benutzerdefinierter Architekturen für spezifische Anwendungsdomänen der konversationellen KI.

Einfluss der Evolution auf konversationelle KI

Der Gesamteinfluss der Evolution von KI-Architekturen auf Konversationssysteme ist transformativ und bringt einen fundamentalen Wandel in ihren Fähigkeiten und ihrem Anwendungspotenzial mit sich. Die multimodale Integration stellt ein Schlüsselelement dieser Transformation dar – moderne Architekturen ermöglichen einen nahtlosen Übergang zwischen Text, Bild, Ton und anderen Modalitäten, was die Konversationsschnittstellen über die Grenzen rein textbasierter Interaktion hinaus erweitert. Diese Integration ermöglicht es KI-Chatbots, visuelle Eingaben zu analysieren, auf multimediale Inhalte zu reagieren und Antworten mit Rich Media zu generieren, die Text mit visuellen oder auditiven Elementen kombinieren. Für einen detaillierteren Blick auf diese Problematik können Sie sich die Analyse autonomer KI-Agenten und multimodaler Systeme ansehen.

Ein paralleler Aspekt ist das kontinuierliche Lernen in Echtzeit, bei dem fortgeschrittene Architekturen ihr Wissen laufend aktualisieren und sich an neue Informationen anpassen können, ohne dass ein komplettes Neutraining erforderlich ist. Dieser Ansatz adressiert eine Schlüsselbeschränkung traditioneller statischer Modelle – die schnelle Veralterung von Wissen in sich dynamisch entwickelnden Domänen. Ein aufkommender architektonischer Ansatz ist auch das lokale Fine-Tuning, das die Leistung des Modells für einen spezifischen Kontext oder Benutzer optimiert, während die generischen Fähigkeiten des Basismodells erhalten bleiben.

Neue Generation von Konversationsassistenten

Der kumulative Effekt dieser architektonischen Innovationen ist das Aufkommen einer neuen Generation von Konversationsassistenten mit qualitativ unterschiedlichen Fähigkeiten. Diese Systeme überschreiten das Paradigma reaktiver Frage-Antwort-Werkzeuge hin zu proaktiven kognitiven Partnern, die zu selbstständigem Denken, kontinuierlichem Lernen und Anpassung an spezifische Benutzerbedürfnisse fähig sind. Praktische Anwendungen umfassen personalisierte Bildungssysteme, die Inhalte und pädagogische Ansätze dynamisch an den Lernstil des Schülers anpassen; Forschungsassistenten, die Hypothesen formulieren und experimentelle Designs vorschlagen können; oder strategische Berater, die substantielle Unterstützung bei komplexen Entscheidungen im Geschäftskontext bieten. Diese Evolution stellt einen signifikanten Schritt hin zu KI-Systemen dar, die als echte kognitive Verstärker fungieren und die menschlichen kognitiven Kapazitäten exponentiell erweitern.