Evolución de las arquitecturas de modelos de IA y tecnologías disruptivas

Modelos de arquitectura más eficientes

El futuro de la inteligencia artificial conversacional está intrínsecamente ligado a la evolución de las arquitecturas de modelos de IA, que están experimentando una rápida transformación hacia una mayor eficiencia y rendimiento. Un aspecto clave de esta evolución es la tecnología Mixture-of-Experts (MoE), que representa un cambio significativo de los modelos monolíticos a un enfoque modular. Esta arquitectura divide la red neuronal en "expertos" especializados que se activan solo para tipos específicos de entradas, lo que aumenta drásticamente la eficiencia de los cálculos.

Una tendencia paralela es la implementación de mecanismos de activación dispersa (sparse activation), que permiten la activación selectiva solo de las partes relevantes del modelo para una tarea específica. A diferencia de las arquitecturas tradicionales, donde se activan todas las neuronas, la activación dispersa reduce drásticamente los requisitos computacionales y permite la construcción de modelos significativamente más grandes manteniendo un tiempo de inferencia eficiente. La consecuencia práctica de estas innovaciones es la posibilidad de implementar chatbots de IA más sofisticados incluso en dispositivos de borde con capacidades computacionales limitadas.

Arquitecturas modulares especializadas

Otra dirección de desarrollo son las arquitecturas modulares especializadas, que combinan componentes genéricos con módulos específicos de dominio. Estos sistemas integran bases genéricas preentrenadas con módulos estrechamente especializados para dominios específicos como medicina, derecho o finanzas, lo que permite alcanzar un nivel experto de conocimiento y capacidades sin necesidad de entrenar todo el modelo desde cero. Este enfoque reduce significativamente los costos de desarrollo y, al mismo tiempo, aumenta la precisión y relevancia de las respuestas en campos específicos.

Expansión de la comprensión contextual

La evolución de la arquitectura de los modelos de IA se dirige hacia una expansión radical de la ventana contextual, lo que representa un cambio fundamental en la capacidad de procesar y responder coherentemente a entradas complejas. Las limitaciones actuales del orden de decenas o cientos de miles de tokens se superarán en las próximas generaciones de modelos hacia millones de tokens o potencialmente hacia un contexto prácticamente ilimitado. Esta expansión permitirá a los sistemas conversacionales mantener interacciones consistentes a largo plazo y procesar documentos extensos como libros completos, trabajos de investigación o manuales técnicos en una sola pasada.

Los habilitadores tecnológicos de esta transformación incluyen el procesamiento jerárquico del contexto, donde el modelo opera con representaciones multinivel, desde el nivel local detallado hasta las abstracciones globales. Otro enfoque innovador es la resumición recursiva, donde el sistema comprime continuamente la información histórica en representaciones densas que conservan la información clave minimizando los requisitos de memoria. Una técnica emergente es también el caché de atención, que optimiza los cálculos repetidos en partes superpuestas del contexto.

Gestión dinámica del contexto

Las arquitecturas avanzadas implementan una gestión dinámica del contexto, que prioriza y selecciona inteligentemente la información relevante en función de su importancia para la conversación actual. Este enfoque combina estrategias como la recuperación de información, el caché local y el almacenamiento de memoria a largo plazo para trabajar eficientemente con una cantidad prácticamente ilimitada de información contextual. El impacto práctico de estas innovaciones es la capacidad de los asistentes de IA para proporcionar respuestas consistentes y contextualmente relevantes incluso dentro de interacciones complejas y multisesión que ocurren durante un período de tiempo más largo.

Capacidades cognitivas avanzadas

Una tendencia fundamental en la evolución de las arquitecturas de IA es el cambio de sistemas puramente reactivos a modelos con capacidades cognitivas avanzadas, que transforman cualitativamente su utilidad para resolver problemas complejos. La nueva generación de sistemas conversacionales demuestra un razonamiento causal significativamente más sofisticado: la capacidad de identificar relaciones causales, distinguir la correlación de la causalidad y construir modelos mentales robustos de los dominios problemáticos. Esta capacidad permite a los chatbots de IA proporcionar análisis más profundos, predicciones más precisas e interpretaciones de datos más valiosas en comparación con las generaciones anteriores.

Una dirección de desarrollo paralela es el progreso en el pensamiento abstracto y analógico, donde los modelos pueden identificar patrones de alto nivel y aplicar conceptos de un dominio a problemas en otro dominio. Esta capacidad es clave para la resolución creativa de problemas, la transferencia interdisciplinaria de conocimientos y la identificación de conexiones no obvias, que a menudo representan el mayor valor en la toma de decisiones complejas. Una dimensión importante es también el desarrollo de capacidades metacognitivas: la capacidad del modelo para reflexionar sobre sus propios procesos de pensamiento, evaluar la calidad de sus respuestas e identificar los límites de su propio conocimiento.

Razonamiento algorítmico y resolución de problemas en múltiples pasos

Las arquitecturas avanzadas demuestran un progreso significativo en el razonamiento algorítmico y la resolución de problemas en múltiples pasos: la capacidad de descomponer problemas complejos en una serie de pasos parciales, resolverlos sistemáticamente e integrar los resultados parciales en una solución coherente. Esta capacidad es esencial para tareas que requieren un enfoque estructurado como derivaciones matemáticas, planificación compleja o depuración de sistemas complejos. En combinación con una mayor precisión (la capacidad de minimizar alucinaciones y errores fácticos), estas capacidades cognitivas avanzadas transforman los chats de IA de herramientas principalmente de comunicación a asistentes cognitivos sofisticados capaces de proporcionar un apoyo sustantivo en la resolución de problemas reales.

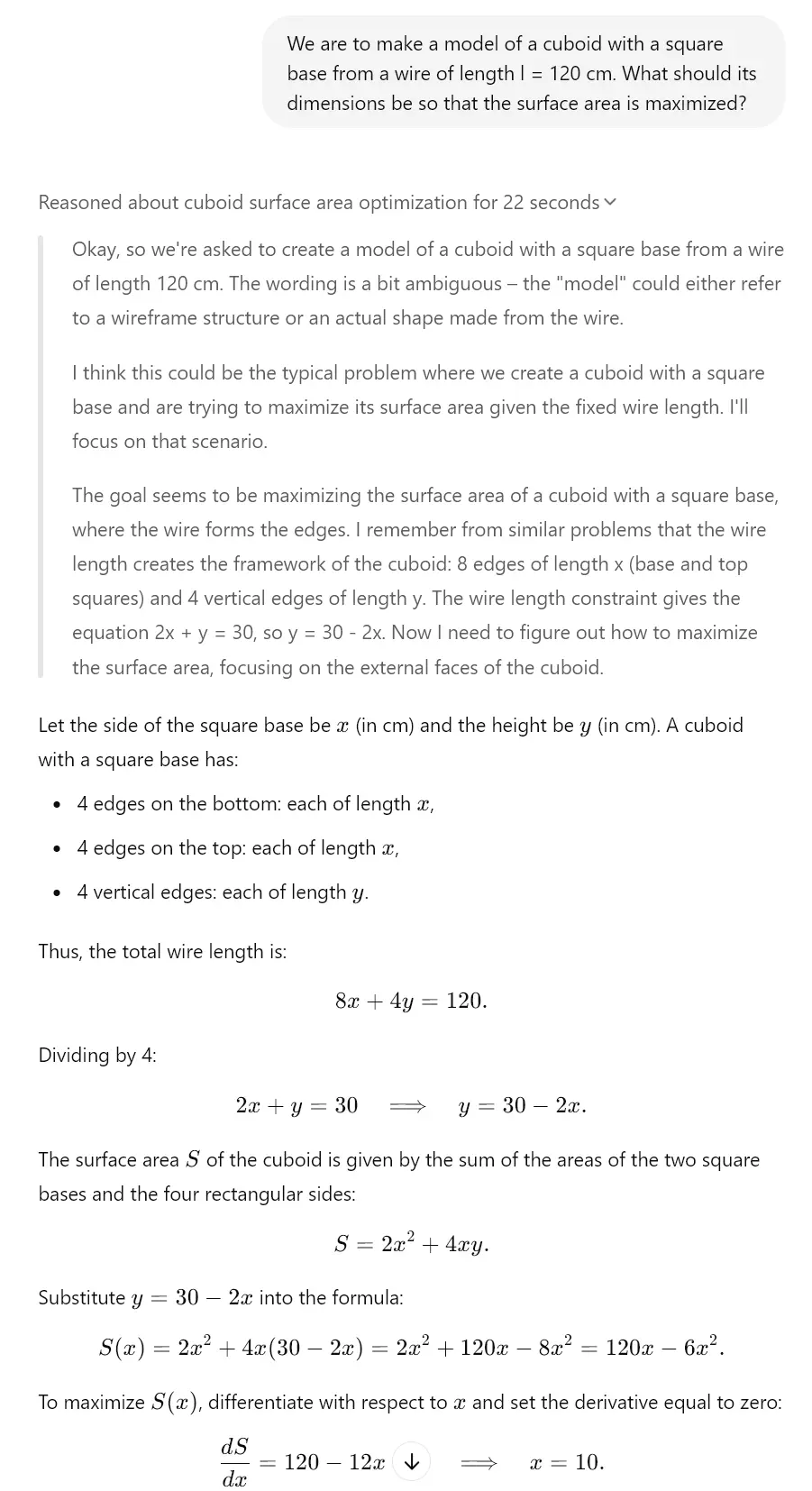

Esto se puede ver finalmente en los modelos "reflexivos" de hoy en día. Por ejemplo, Gemini 2.0, Claude 3.7 Sonnet o ChatGPT o1 tienen estas funciones. Eche un vistazo al ejemplo que hemos creado para usted gracias al modelo o3-mini, que tiene un mecanismo reflexivo similar.

Optimización de parámetros y resultados

Un aspecto crítico de la evolución de las arquitecturas de IA es la optimización continua de parámetros y resultados, que aumenta la eficiencia y la calidad del contenido generado. Las técnicas de cuantización representan un avance significativo en la compresión de modelos y son métodos para reducir los requisitos de memoria y computacionales manteniendo la mayor parte del rendimiento original. Los enfoques modernos como la cuantización post-entrenamiento y la inferencia con precisión mixta permiten reducir el tamaño de los modelos hasta en un 75% con una degradación mínima del rendimiento, lo que amplía drásticamente el espectro de dispositivos capaces de alojar sistemas sofisticados de IA conversacional.

Una tendencia paralela es la optimización mediante la destilación del conocimiento, donde el conocimiento de grandes modelos "maestros" se transfiere a modelos "estudiantes" más compactos. Este proceso comprime eficazmente la información capturada en redes neuronales complejas en arquitecturas más pequeñas que pueden implementarse en entornos con recursos limitados. Un potencial significativo también lo representan las optimizaciones específicas de hardware, donde la arquitectura del modelo se adapta específicamente para obtener el máximo rendimiento en un hardware concreto (CPU, GPU, TPU, chips neuromórficos), lo que permite alcanzar una velocidad de inferencia significativamente mayor.

Mecanismos de salida adaptativos

Las arquitecturas avanzadas implementan mecanismos de salida adaptativos, que ajustan dinámicamente la generación de respuestas en función del contexto, los requisitos de precisión y los recursos computacionales disponibles. Estos sistemas equilibran inteligentemente la calidad, la velocidad y la eficiencia mediante técnicas como la inferencia con terminación temprana y el renderizado progresivo. La consecuencia práctica de estas optimizaciones es la capacidad de implementar asistentes de IA altamente sofisticados incluso en escenarios de edge computing como la movilidad, los dispositivos IoT o los dispositivos portátiles para la realidad aumentada, donde los modelos de lenguaje grandes tradicionales son inutilizables debido a las limitaciones de recursos.

Redes neuronales y su desarrollo

Un aspecto fundamental de la evolución de los modelos de IA es la innovación en la arquitectura de las redes neuronales, que define sus capacidades y límites. Las arquitecturas híbridas que combinan diferentes tipos de redes neuronales para maximizar sus fortalezas tienen un potencial transformador. Estos sistemas integran modelos basados en transformadores optimizados para la comprensión de texto con redes convolucionales para el análisis visual, redes recurrentes para datos secuenciales y redes neuronales de grafos para información estructurada, lo que permite la creación de sistemas versátiles capaces de operar en diferentes dominios y tipos de datos.

Otra dirección de desarrollo son los transformadores recurrentes, que abordan las limitaciones de las arquitecturas de transformadores estándar en el procesamiento secuencial y el razonamiento temporal. Estos modelos implementan mecanismos recurrentes como el seguimiento del estado y el refinamiento iterativo, lo que mejora significativamente su capacidad para modelar procesos dinámicos, razonamiento gradual y dependencias secuenciales complejas. Esta capacidad es esencial para tareas como la simulación, la planificación estratégica o las predicciones a largo plazo, que requieren una comprensión sofisticada de las relaciones temporales.

Arquitecturas automodificables y autoperfeccionables

Una tendencia emergente son las arquitecturas automodificables y autoperfeccionables, que pueden adaptar su estructura y parámetros en respuesta a tareas específicas. Estos sistemas implementan mecanismos de metaaprendizaje que optimizan continuamente su configuración interna basándose en bucles de retroalimentación y métricas de rendimiento. Una dimensión clave es también la búsqueda de arquitecturas neuronales (NAS), donde los sistemas de IA diseñan y optimizan automáticamente nuevas arquitecturas de redes neuronales adaptadas específicamente a casos de uso concretos. Este enfoque acelera la iteración de los modelos de IA y permite la creación de arquitecturas personalizadas altamente eficientes para dominios de aplicación específicos de la IA conversacional.

Impacto de la evolución en la IA conversacional

El impacto general de la evolución de las arquitecturas de IA en los sistemas conversacionales es transformador, aportando un cambio fundamental en sus capacidades y potencial de aplicación. La integración multimodal representa un elemento clave de esta transformación: las arquitecturas modernas permiten una transición fluida entre texto, imagen, sonido y otras modalidades, lo que amplía las interfaces conversacionales más allá de la interacción puramente textual. Esta integración permite a los chatbots de IA analizar entradas visuales, responder a contenido multimedia y generar respuestas con medios enriquecidos que combinan texto con elementos visuales o auditivos. Para una visión más detallada de esta problemática, puede consultar el análisis de agentes de IA autónomos y sistemas multimodales.

Un aspecto paralelo es el aprendizaje continuo en tiempo real, donde las arquitecturas avanzadas pueden actualizar continuamente sus conocimientos y adaptarse a nueva información sin necesidad de un reentrenamiento completo. Este enfoque aborda una limitación clave de los modelos estáticos tradicionales: la rápida obsolescencia del conocimiento en dominios que evolucionan dinámicamente. Un enfoque arquitectónico emergente es también el ajuste fino local (local fine-tuning), que optimiza el rendimiento del modelo para un contexto o usuario específico manteniendo las capacidades genéricas del modelo base.

Nueva generación de asistentes conversacionales

El efecto acumulativo de estas innovaciones arquitectónicas es la aparición de una nueva generación de asistentes conversacionales con capacidades cualitativamente diferentes. Estos sistemas superan el paradigma de las herramientas reactivas de preguntas y respuestas hacia socios cognitivos proactivos capaces de razonamiento independiente, aprendizaje continuo y adaptación a las necesidades específicas de los usuarios. Las aplicaciones prácticas incluyen sistemas educativos personalizados que adaptan dinámicamente el contenido y el enfoque pedagógico al estilo de aprendizaje del estudiante; asistentes de investigación capaces de formular hipótesis y proponer diseños experimentales; o asesores estratégicos que proporcionan un apoyo sustantivo en la toma de decisiones complejas en un contexto empresarial. Esta evolución representa un avance significativo hacia sistemas de IA que funcionan como verdaderos amplificadores cognitivos que expanden exponencialmente las capacidades cognitivas humanas.