Évolution des architectures de modèles d'IA et technologies de rupture

Modèles d'architectures plus efficaces

L'avenir de l'intelligence artificielle conversationnelle est intrinsèquement lié à l'évolution des architectures de modèles d'IA, qui subissent une transformation rapide vers une efficacité et des performances accrues. Un aspect clé de cette évolution est la technologie Mixture-of-Experts (MoE), qui représente un changement significatif des modèles monolithiques vers une approche modulaire. Cette architecture divise le réseau neuronal en "experts" spécialisés qui ne sont activés que pour des types d'entrées spécifiques, ce qui augmente considérablement l'efficacité des calculs.

Une tendance parallèle est la mise en œuvre de mécanismes d'activation clairsemée (sparse activation), qui permettent l'activation sélective uniquement des parties pertinentes du modèle pour une tâche spécifique. Contrairement aux architectures traditionnelles où tous les neurones sont activés, l'activation clairsemée réduit considérablement les besoins en calcul et permet la construction de modèles nettement plus grands tout en maintenant un temps d'inférence efficace. La conséquence pratique de ces innovations est la possibilité de déployer des chatbots IA plus sophistiqués même sur des appareils périphériques aux capacités de calcul limitées.

Architectures modulaires spécialisées

Une autre direction de développement est représentée par les architectures modulaires spécialisées, qui combinent des composants génériques avec des modules spécifiques à un domaine. Ces systèmes intègrent des bases génériques pré-entraînées avec des modules hautement spécialisés pour des domaines spécifiques tels que la médecine, le droit ou la finance, ce qui permet d'atteindre un niveau expert de connaissances et de capacités sans avoir besoin d'entraîner l'ensemble du modèle à partir de zéro. Cette approche réduit considérablement les coûts de développement tout en augmentant la précision et la pertinence des réponses dans des domaines spécifiques.

Expansion de la compréhension contextuelle

L'évolution de l'architecture des modèles d'IA s'oriente vers une expansion radicale de la fenêtre contextuelle, ce qui représente un changement fondamental dans la capacité à traiter et à répondre de manière cohérente à des entrées complexes. Les limitations actuelles de l'ordre de dizaines ou de centaines de milliers de tokens seront dépassées dans les prochaines générations de modèles pour atteindre des millions de tokens, voire potentiellement un contexte pratiquement illimité. Cette expansion permettra aux systèmes conversationnels de maintenir des interactions cohérentes à long terme et de traiter des documents volumineux tels que des livres complets, des travaux de recherche ou des manuels techniques en une seule passe.

Les facilitateurs technologiques de cette transformation incluent le traitement hiérarchique du contexte, où le modèle opère avec des représentations multi-niveaux - du niveau local détaillé aux abstractions globales. Une autre approche innovante est la sommarisation récursive, où le système compresse en continu les informations historiques en représentations denses qui préservent les informations clés tout en minimisant les besoins en mémoire. Une technique émergente est également la mise en cache de l'attention, qui optimise les calculs répétitifs sur les parties contextuelles qui se chevauchent.

Gestion dynamique du contexte

Les architectures avancées mettent en œuvre une gestion dynamique du contexte, qui priorise et sélectionne intelligemment les informations pertinentes en fonction de leur importance pour la conversation en cours. Cette approche combine des stratégies telles que la recherche d'informations, le cache local et le stockage de la mémoire à long terme pour travailler efficacement avec une quantité pratiquement illimitée d'informations contextuelles. L'impact pratique de ces innovations est la capacité des assistants IA à fournir des réponses cohérentes et contextuellement pertinentes même dans le cadre d'interactions complexes multi-sessions se déroulant sur une plus longue période.

Capacités cognitives avancées

Une tendance fondamentale dans l'évolution des architectures d'IA est le passage de systèmes purement réactifs à des modèles dotés de capacités cognitives avancées, qui transforment qualitativement leur utilité dans la résolution de problèmes complexes. La nouvelle génération de systèmes conversationnels démontre un raisonnement causal nettement plus sophistiqué - la capacité d'identifier les relations de cause à effet, de distinguer la corrélation de la causalité et de construire des modèles mentaux robustes des domaines problématiques. Cette capacité permet aux chatbots IA de fournir des analyses plus approfondies, des prédictions plus précises et des interprétations de données plus précieuses par rapport aux générations précédentes.

Une direction de développement parallèle est le progrès dans la pensée abstraite et analogique, où les modèles peuvent identifier des motifs de haut niveau et appliquer des concepts d'un domaine à des problèmes dans un autre domaine. Cette capacité est essentielle pour la résolution créative de problèmes, le transfert interdisciplinaire de connaissances et l'identification de liens non évidents, qui représentent souvent la plus grande valeur dans la prise de décision complexe. Le développement des capacités méta-cognitives représente également une dimension importante - la capacité du modèle à réfléchir à ses propres processus de pensée, à évaluer la qualité de ses réponses et à identifier les limites de ses propres connaissances.

Raisonnement algorithmique et résolution de problèmes en plusieurs étapes

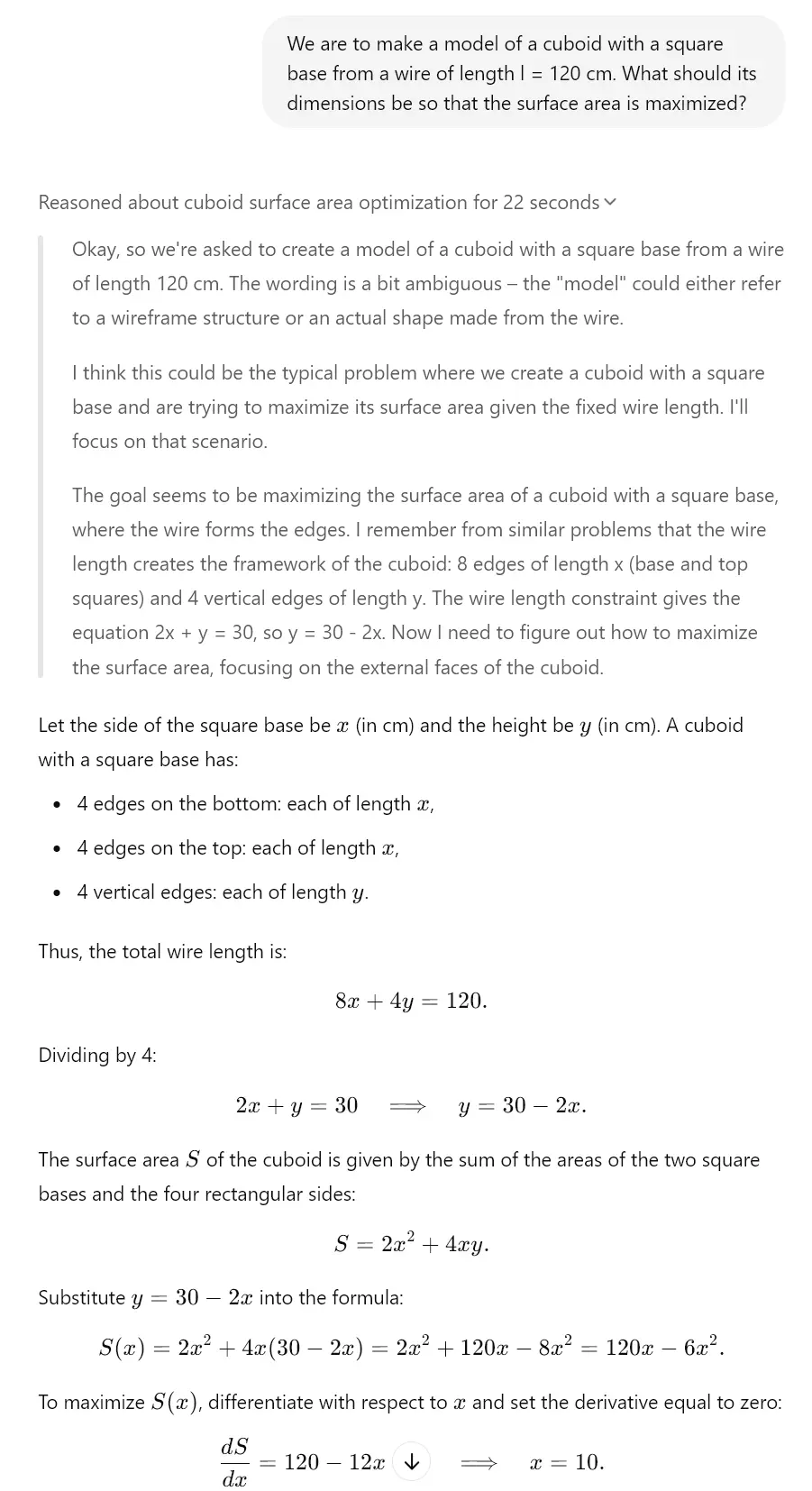

Les architectures avancées démontrent des progrès significatifs dans le raisonnement algorithmique et la résolution de problèmes en plusieurs étapes - la capacité de décomposer des problèmes complexes en une série d'étapes partielles, de les résoudre systématiquement et d'intégrer les résultats partiels dans une solution cohérente. Cette capacité est essentielle pour les tâches nécessitant une approche structurée telles que les dérivations mathématiques, la planification complexe ou le débogage de systèmes complexes. Combinées à une précision accrue (la capacité de minimiser les hallucinations et les erreurs factuelles), ces capacités cognitives avancées transforment les chats IA d'outils principalement de communication en assistants cognitifs sophistiqués capables de fournir un soutien substantiel dans la résolution de problèmes réels.

C'est d'ailleurs ce que l'on observe déjà aujourd'hui avec les modèles "réfléchis". Par exemple, Gemini 2.0, Claude 3.7 Sonnet ou ChatGPT o1 disposent de ces fonctions. Jetez un œil à l'exemple que nous avons créé pour vous grâce au modèle o3-mini, qui possède un mécanisme de réflexion similaire.

Optimisation des paramètres et des sorties

Un aspect critique de l'évolution des architectures d'IA est l'optimisation continue des paramètres et des sorties, qui augmente l'efficacité et la qualité du contenu généré. Les techniques de quantification représentent une avancée significative dans la compression des modèles et sont des méthodes de réduction de la charge mémoire et de calcul tout en préservant la majeure partie des performances d'origine. Les approches modernes telles que la quantification post-entraînement et l'inférence en précision mixte permettent de réduire la taille des modèles jusqu'à 75% avec une dégradation minimale des performances, ce qui élargit considérablement le spectre des appareils capables d'héberger des systèmes d'IA conversationnelle sophistiqués.

Une tendance parallèle est l'optimisation par distillation des connaissances, où les connaissances de grands modèles "enseignants" sont transférées à des modèles "étudiants" plus compacts. Ce processus compresse efficacement les informations capturées dans des réseaux neuronaux complexes en architectures plus petites qui peuvent être déployées dans des environnements aux ressources limitées. Les optimisations spécifiques au matériel représentent également un potentiel significatif, où l'architecture du modèle est spécifiquement adaptée pour des performances maximales sur un matériel spécifique (CPU, GPU, TPU, puces neuromorphiques), ce qui permet d'atteindre une vitesse d'inférence nettement plus élevée.

Mécanismes de sortie adaptatifs

Les architectures avancées implémentent des mécanismes de sortie adaptatifs, qui adaptent dynamiquement la génération de réponses en fonction du contexte, des exigences de précision et des ressources de calcul disponibles. Ces systèmes équilibrent intelligemment la qualité, la vitesse et l'efficacité grâce à des techniques telles que l'inférence avec arrêt précoce et le rendu progressif. La conséquence pratique de ces optimisations est la capacité de déployer des assistants IA hautement sophistiqués même dans des scénarios d'edge computing tels que la mobilité, les appareils IoT ou les appareils portables pour la réalité augmentée, où les grands modèles de langage traditionnels sont inutilisables en raison des limitations de ressources.

Réseaux neuronaux et leur évolution

Un aspect fondamental de l'évolution des modèles d'IA est l'innovation dans l'architecture des réseaux neuronaux, qui définit leurs capacités et leurs limites. Les architectures hybrides combinant différents types de réseaux neuronaux pour maximiser leurs forces ont un potentiel de transformation. Ces systèmes intègrent des modèles basés sur des transformeurs optimisés pour la compréhension de texte avec des réseaux convolutifs pour l'analyse visuelle, des réseaux récurrents pour les données séquentielles et des réseaux neuronaux graphiques pour les informations structurées, ce qui permet de créer des systèmes polyvalents capables d'opérer dans différents domaines et types de données.

Une autre direction de développement est représentée par les transformeurs récurrents, qui traitent les limitations des architectures de transformeurs standard dans le domaine du traitement séquentiel et du raisonnement temporel. Ces modèles implémentent des mécanismes récurrents tels que le suivi d'état et l'affinement itératif, ce qui améliore considérablement leur capacité à modéliser des processus dynamiques, un raisonnement progressif et des dépendances séquentielles complexes. Cette capacité est essentielle pour des tâches telles que la simulation, la planification stratégique ou les prédictions à long terme, qui nécessitent une compréhension sophistiquée des relations temporelles.

Architectures auto-modifiantes et auto-améliorantes

Une tendance émergente est représentée par les architectures auto-modifiantes et auto-améliorantes, qui peuvent adapter leur structure et leurs paramètres en réponse à des tâches spécifiques. Ces systèmes implémentent des mécanismes de méta-apprentissage qui optimisent continuellement leur configuration interne en fonction des boucles de rétroaction et des métriques de performance. La recherche d'architecture neuronale (NAS) représente également une dimension clé, où les systèmes d'IA conçoivent et optimisent automatiquement de nouvelles architectures de réseaux neuronaux spécifiquement adaptées à des cas d'utilisation concrets. Cette approche accélère l'itération des modèles d'IA et permet la création d'architectures personnalisées très efficaces pour des domaines d'application spécifiques de l'IA conversationnelle.

Impact de l'évolution sur l'IA conversationnelle

L'impact global de l'évolution des architectures d'IA sur les systèmes conversationnels est transformateur, apportant un changement fondamental dans leurs capacités et leur potentiel d'application. L'intégration multimodale représente un élément clé de cette transformation - les architectures modernes permettent une transition fluide entre le texte, l'image, le son et d'autres modalités, ce qui étend les interfaces conversationnelles au-delà des limites de l'interaction purement textuelle. Cette intégration permet aux chatbots IA d'analyser les entrées visuelles, de réagir au contenu multimédia et de générer des réponses avec des médias riches combinant du texte avec des éléments visuels ou auditifs. Pour un aperçu plus détaillé de cette problématique, vous pouvez consulter l'analyse des agents IA autonomes et des systèmes multimodaux.

Un aspect parallèle est l'apprentissage continu en temps réel, où les architectures avancées peuvent mettre à jour en permanence leurs connaissances et s'adapter aux nouvelles informations sans nécessiter un réentraînement complet. Cette approche répond à une limitation clé des modèles statiques traditionnels - l'obsolescence rapide des connaissances dans des domaines en évolution dynamique. Une approche architecturale émergente est également le réglage fin local (local fine-tuning), qui optimise les performances du modèle pour un contexte ou un utilisateur spécifique tout en conservant les capacités génériques du modèle de base.

Nouvelle génération d'assistants conversationnels

L'effet cumulatif de ces innovations architecturales est l'émergence d'une nouvelle génération d'assistants conversationnels dotés de capacités qualitativement différentes. Ces systèmes dépassent le paradigme des outils réactifs de questions-réponses pour devenir des partenaires cognitifs proactifs capables de raisonnement autonome, d'apprentissage continu et d'adaptation aux besoins spécifiques des utilisateurs. Les applications pratiques incluent des systèmes éducatifs personnalisés adaptant dynamiquement le contenu et l'approche pédagogique au style d'apprentissage de l'étudiant ; des assistants de recherche capables de formuler des hypothèses et de proposer des conceptions expérimentales ; ou des conseillers stratégiques fournissant un soutien substantiel à la prise de décision complexe dans un contexte commercial. Cette évolution représente une avancée significative vers des systèmes d'IA qui fonctionnent comme de véritables amplificateurs cognitifs, élargissant de manière exponentielle les capacités cognitives humaines.