Evoluzione delle architetture dei modelli di IA e tecnologie rivoluzionarie

Modelli di architetture più efficienti

Il futuro dell'intelligenza artificiale conversazionale è intrinsecamente legato all'evoluzione delle architetture dei modelli di IA, che stanno subendo una rapida trasformazione verso una maggiore efficienza e prestazioni. Un aspetto chiave di questa evoluzione è la tecnologia Mixture-of-Experts (MoE), che rappresenta un significativo passaggio dai modelli monolitici a un approccio modulare. Questa architettura divide la rete neurale in "esperti" specializzati che vengono attivati solo per tipi specifici di input, aumentando drasticamente l'efficienza dei calcoli.

Una tendenza parallela è l'implementazione di meccanismi di attivazione sparsa (sparse activation), che consentono l'attivazione selettiva solo delle parti rilevanti del modello per un compito specifico. A differenza delle architetture tradizionali, dove tutti i neuroni vengono attivati, l'attivazione sparsa riduce drasticamente le esigenze computazionali e consente la costruzione di modelli significativamente più grandi mantenendo un tempo di inferenza efficiente. La conseguenza pratica di queste innovazioni è la possibilità di implementare chatbot IA più sofisticati anche su dispositivi edge con capacità computazionali limitate.

Architetture modulari specializzate

Un'altra direzione di sviluppo è rappresentata dalle architetture modulari specializzate, che combinano componenti generici con moduli specifici per dominio. Questi sistemi integrano basi generiche pre-addestrate con moduli altamente specializzati per domini specifici come medicina, diritto o finanza, consentendo di raggiungere un livello esperto di conoscenza e capacità senza la necessità di addestrare l'intero modello da zero. Questo approccio riduce significativamente i costi di sviluppo e allo stesso tempo aumenta l'accuratezza e la pertinenza delle risposte in settori specifici.

Espansione della comprensione contestuale

L'evoluzione dell'architettura dei modelli di IA si sta dirigendo verso una radicale espansione della finestra contestuale, che rappresenta un cambiamento fondamentale nella capacità di elaborare e rispondere in modo coerente a input complessi. Le attuali limitazioni dell'ordine di decine o centinaia di migliaia di token saranno superate nelle prossime generazioni di modelli, puntando a milioni di token o potenzialmente a un contesto praticamente illimitato. Questa espansione consentirà ai sistemi conversazionali di mantenere interazioni coerenti a lungo termine e di elaborare documenti estesi come libri completi, articoli di ricerca o manuali tecnici in un unico passaggio.

Gli abilitatori tecnologici di questa trasformazione includono l'elaborazione gerarchica del contesto, in cui il modello opera con rappresentazioni multi-livello - dal livello locale dettagliato alle astrazioni globali. Un altro approccio innovativo è la sommarizzazione ricorsiva, in cui il sistema comprime continuamente le informazioni storiche in rappresentazioni dense che conservano le informazioni chiave minimizzando i requisiti di memoria. Una tecnica emergente è anche il caching dell'attenzione, che ottimizza i calcoli ripetuti su parti sovrapposte del contesto.

Gestione dinamica del contesto

Le architetture avanzate implementano la gestione dinamica del contesto, che prioritizza e seleziona in modo intelligente le informazioni rilevanti in base alla loro importanza per la conversazione corrente. Questo approccio combina strategie come il recupero delle informazioni, la cache locale e l'archiviazione della memoria a lungo termine per lavorare efficacemente con una quantità praticamente illimitata di informazioni contestuali. L'impatto pratico di queste innovazioni è la capacità degli assistenti IA di fornire risposte coerenti e contestualmente rilevanti anche all'interno di interazioni complesse e multi-sessione che si svolgono su un orizzonte temporale più lungo.

Capacità cognitive avanzate

Una tendenza fondamentale nell'evoluzione delle architetture IA è il passaggio da sistemi puramente reattivi a modelli con capacità cognitive avanzate, che trasformano qualitativamente la loro utilità nella risoluzione di problemi complessi. La nuova generazione di sistemi conversazionali dimostra un ragionamento causale significativamente più sofisticato - la capacità di identificare relazioni causali, distinguere la correlazione dalla causalità e costruire modelli mentali robusti dei domini problematici. Questa capacità consente ai chatbot IA di fornire analisi più approfondite, previsioni più accurate e interpretazioni dei dati più preziose rispetto alle generazioni precedenti.

Una direzione di sviluppo parallela è il progresso nel pensiero astratto e analogico, in cui i modelli sono in grado di identificare pattern di alto livello e applicare concetti da un dominio a problemi in un altro dominio. Questa capacità è fondamentale per la risoluzione creativa dei problemi, il trasferimento interdisciplinare delle conoscenze e l'identificazione di connessioni non ovvie, che spesso rappresentano il valore più alto nel processo decisionale complesso. Una dimensione importante è anche lo sviluppo di capacità meta-cognitive - la capacità del modello di riflettere sui propri processi di pensiero, valutare la qualità delle proprie risposte e identificare i limiti delle proprie conoscenze.

Ragionamento algoritmico e risoluzione di problemi multi-step

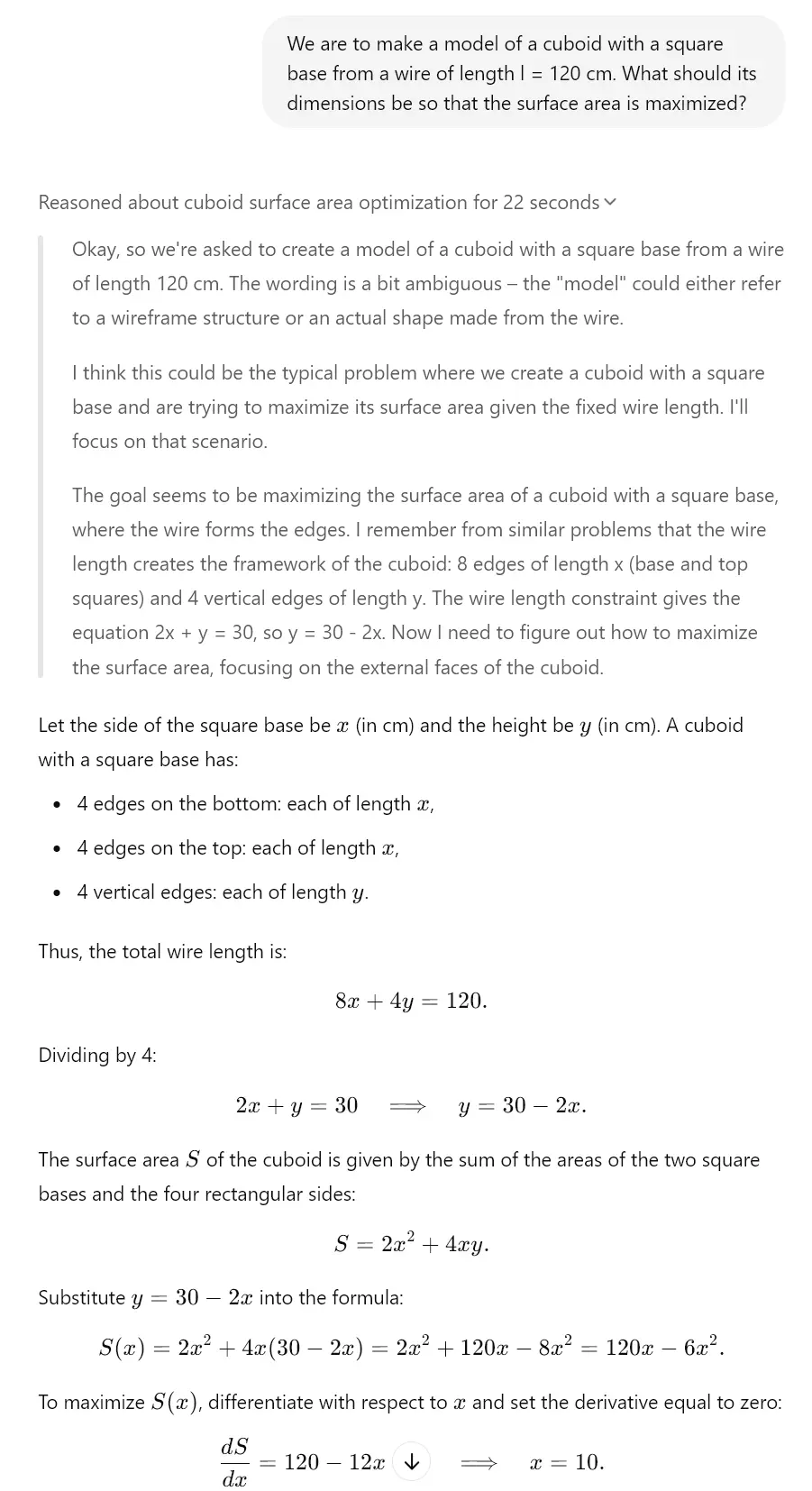

Le architetture avanzate dimostrano progressi significativi nel ragionamento algoritmico e nella risoluzione di problemi multi-step - la capacità di scomporre problemi complessi in una serie di passaggi parziali, risolverli sistematicamente e integrare i risultati parziali in una soluzione coerente. Questa capacità è essenziale per compiti che richiedono un approccio strutturato come derivazioni matematiche, pianificazione complessa o debugging di sistemi complessi. In combinazione con una maggiore accuratezza (la capacità di minimizzare allucinazioni ed errori fattuali), queste capacità cognitive avanzate trasformano le chat IA da strumenti principalmente comunicativi ad assistenti cognitivi sofisticati in grado di fornire un supporto sostanziale nella risoluzione di problemi reali.

Questo è, dopotutto, già visibile oggi nei modelli "riflessivi". Ad esempio, Gemini 2.0, Claude 3.7 Sonnet o ChatGPT o1 hanno queste funzioni. Dai un'occhiata all'esempio che abbiamo creato per te utilizzando il modello o3-mini, che ha un meccanismo riflessivo simile.

Ottimizzazione dei parametri e degli output

Un aspetto critico dell'evoluzione delle architetture IA è l'ottimizzazione continua dei parametri e degli output, che aumenta l'efficienza e la qualità dei contenuti generati. Le tecniche di quantizzazione rappresentano un passo significativo nella compressione dei modelli e sono metodi per ridurre i requisiti di memoria e computazionali preservando la maggior parte delle prestazioni originali. Approcci moderni come la quantizzazione post-addestramento e l'inferenza a precisione mista consentono di ridurre le dimensioni dei modelli fino al 75% con una minima degradazione delle prestazioni, ampliando drasticamente la gamma di dispositivi in grado di ospitare sofisticati sistemi di IA conversazionale.

Una tendenza parallela è l'ottimizzazione attraverso la distillazione della conoscenza, in cui la conoscenza da grandi modelli "insegnanti" viene trasferita a modelli "studenti" più compatti. Questo processo comprime efficacemente le informazioni catturate in complesse reti neurali in architetture più piccole che possono essere implementate in ambienti con risorse limitate. Un potenziale significativo è rappresentato anche dalle ottimizzazioni specifiche per l'hardware, in cui l'architettura del modello viene specificamente adattata per massimizzare le prestazioni su hardware specifico (CPU, GPU, TPU, chip neuromorfici), consentendo di raggiungere velocità di inferenza significativamente più elevate.

Meccanismi di output adattivi

Le architetture avanzate implementano meccanismi di output adattivi, che adattano dinamicamente la generazione delle risposte in base al contesto, ai requisiti di accuratezza e alle risorse computazionali disponibili. Questi sistemi bilanciano intelligentemente tra qualità, velocità ed efficienza attraverso tecniche come l'inferenza con terminazione anticipata e il rendering progressivo. La conseguenza pratica di queste ottimizzazioni è la capacità di implementare assistenti IA altamente sofisticati anche in scenari di edge computing come mobilità, dispositivi IoT o dispositivi indossabili per la realtà aumentata, dove i tradizionali modelli linguistici di grandi dimensioni sono inutilizzabili a causa delle limitazioni delle risorse.

Reti neurali e loro sviluppo

Un aspetto fondamentale dell'evoluzione dei modelli IA è l'innovazione nell'architettura delle reti neurali, che definisce le loro capacità e limiti. Le architetture ibride che combinano diversi tipi di reti neurali per massimizzare i loro punti di forza hanno un potenziale trasformativo. Questi sistemi integrano modelli basati su transformer ottimizzati per la comprensione del testo con reti convoluzionali per l'analisi visiva, reti ricorrenti per dati sequenziali e reti neurali grafiche per informazioni strutturate, consentendo la creazione di sistemi versatili in grado di operare su diversi domini e tipi di dati.

Un'altra direzione di sviluppo è rappresentata dai transformer ricorrenti, che affrontano le limitazioni delle architetture transformer standard nell'elaborazione sequenziale e nel ragionamento temporale. Questi modelli implementano meccanismi ricorrenti come il tracciamento dello stato e il perfezionamento iterativo, migliorando significativamente la loro capacità di modellare processi dinamici, ragionamento graduale e dipendenze sequenziali complesse. Questa capacità è essenziale per compiti come la simulazione, la pianificazione strategica o le previsioni a lungo termine, che richiedono una sofisticata comprensione delle relazioni temporali.

Architetture auto-modificanti e auto-miglioranti

Una tendenza emergente è rappresentata dalle architetture auto-modificanti e auto-miglioranti, che possono adattare la loro struttura e i parametri in risposta a compiti specifici. Questi sistemi implementano meccanismi di meta-apprendimento che ottimizzano continuamente la loro configurazione interna sulla base di cicli di feedback e metriche di performance. Una dimensione chiave è anche la ricerca di architetture neurali (NAS), in cui i sistemi IA progettano e ottimizzano automaticamente nuove architetture di reti neurali specificamente adattate a casi d'uso concreti. Questo approccio accelera l'iterazione dei modelli IA e consente la creazione di architetture personalizzate altamente efficienti per specifici domini applicativi dell'IA conversazionale.

Impatto dell'evoluzione sull'IA conversazionale

L'impatto complessivo dell'evoluzione delle architetture IA sui sistemi conversazionali è trasformativo, portando un cambiamento fondamentale nelle loro capacità e nel potenziale applicativo. L'integrazione multimodale rappresenta un elemento chiave di questa trasformazione: le architetture moderne consentono una transizione fluida tra testo, immagine, suono e altre modalità, estendendo le interfacce conversazionali oltre i limiti dell'interazione puramente testuale. Questa integrazione consente ai chatbot IA di analizzare input visivi, rispondere a contenuti multimediali e generare risposte con media ricchi che combinano testo con elementi visivi o uditivi. Per uno sguardo più dettagliato su questo argomento, puoi consultare l'analisi degli agenti IA autonomi e dei sistemi multimodali.

Un aspetto parallelo è l'apprendimento continuo in tempo reale, in cui le architetture avanzate possono aggiornare continuamente le proprie conoscenze e adattarsi a nuove informazioni senza la necessità di un riaddestramento completo. Questo approccio affronta una limitazione chiave dei modelli statici tradizionali: la rapida obsolescenza della conoscenza in domini in evoluzione dinamica. Un approccio architettonico emergente è anche il fine-tuning locale, che ottimizza le prestazioni del modello per un contesto o utente specifico preservando le capacità generiche del modello di base.

Nuova generazione di assistenti conversazionali

L'effetto cumulativo di queste innovazioni architettoniche è l'emergere di una nuova generazione di assistenti conversazionali con capacità qualitativamente diverse. Questi sistemi superano il paradigma degli strumenti reattivi per domande e risposte verso partner cognitivi proattivi capaci di ragionamento autonomo, apprendimento continuo e adattamento alle esigenze specifiche degli utenti. Le applicazioni pratiche includono sistemi educativi personalizzati che adattano dinamicamente i contenuti e l'approccio pedagogico allo stile di apprendimento dello studente; assistenti di ricerca in grado di formulare ipotesi e proporre progetti sperimentali; o consulenti strategici che forniscono supporto sostanziale nel processo decisionale complesso in contesti aziendali. Questa evoluzione rappresenta un significativo passo avanti verso sistemi IA che funzionano come veri amplificatori cognitivi, espandendo esponenzialmente le capacità cognitive umane.