Evolutie van AI-modelarchitecturen en baanbrekende technologieën

Efficiëntere modelarchitecturen

De toekomst van conversationele kunstmatige intelligentie is onlosmakelijk verbonden met de evolutie van AI-modelarchitecturen, die een snelle transformatie ondergaan naar hogere efficiëntie en prestaties. Een sleutelaspect van deze evolutie is de Mixture-of-Experts (MoE) technologie, die een significante verschuiving vertegenwoordigt van monolithische modellen naar een modulaire aanpak. Deze architectuur verdeelt het neurale netwerk in gespecialiseerde 'experts' die alleen worden geactiveerd voor specifieke soorten input, wat de rekenefficiëntie drastisch verhoogt.

Een parallelle trend is de implementatie van mechanismen voor sparse activation, die selectieve activering van alleen relevante delen van het model voor een specifieke taak mogelijk maken. In tegenstelling tot traditionele architecturen, waar alle neuronen worden geactiveerd, vermindert sparse activation de rekenvereisten drastisch en maakt het de constructie van significant grotere modellen mogelijk met behoud van efficiënte inferentietijd. Een praktisch gevolg van deze innovaties is de mogelijkheid om geavanceerdere AI-chatbots in te zetten, zelfs op edge-apparaten met beperkte rekencapaciteit.

Gespecialiseerde modulaire architecturen

Een andere ontwikkelingsrichting wordt vertegenwoordigd door gespecialiseerde modulaire architecturen, die generieke componenten combineren met domeinspecifieke modules. Deze systemen integreren vooraf getrainde generieke fundamenten met nauw gespecialiseerde modules voor specifieke domeinen zoals geneeskunde, recht of financiën, waardoor een expertniveau van kennis en vaardigheden kan worden bereikt zonder de noodzaak om het hele model vanaf nul te trainen. Deze aanpak vermindert de ontwikkelingskosten aanzienlijk en verhoogt tegelijkertijd de nauwkeurigheid en relevantie van antwoorden in specifieke vakgebieden.

Uitbreiding van contextueel begrip

De evolutie van AI-modelarchitectuur leidt tot een radicale uitbreiding van het contextvenster, wat een fundamentele verschuiving betekent in het vermogen om complexe input te verwerken en coherent te reageren. De huidige beperkingen van tienduizenden of honderdduizenden tokens zullen in de komende generaties modellen worden overschreden richting miljoenen tokens of potentieel een praktisch onbeperkte context. Deze uitbreiding stelt conversatiesystemen in staat om consistente langdurige interacties te onderhouden en omvangrijke documenten zoals complete boeken, onderzoeksartikelen of technische handleidingen in één keer te verwerken.

Technologische enablers van deze transformatie omvatten hiërarchische contextverwerking, waarbij het model werkt met representaties op meerdere niveaus - van gedetailleerd lokaal niveau tot globale abstracties. Een andere innovatieve benadering is recursieve samenvatting, waarbij het systeem continu historische informatie comprimeert tot dichte representaties die belangrijke informatie behouden terwijl de geheugenvereisten worden geminimaliseerd. Een opkomende techniek is ook attention caching, die herhaalde berekeningen op overlappende delen van de context optimaliseert.

Dynamisch contextbeheer

Geavanceerde architecturen implementeren dynamisch contextbeheer, dat op intelligente wijze relevante informatie prioriteert en selecteert op basis van het belang ervan voor het huidige gesprek. Deze aanpak combineert strategieën zoals informatie ophalen, lokale cache en langetermijngeheugenopslag voor efficiënt werken met praktisch onbeperkte hoeveelheden contextuele informatie. Het praktische effect van deze innovaties is het vermogen van AI-assistenten om consistente, contextueel relevante antwoorden te geven, zelfs binnen complexe, multi-sessie interacties die over een langere periode plaatsvinden.

Geavanceerde cognitieve vaardigheden

Een fundamentele trend in de evolutie van AI-architecturen is de verschuiving van puur reactieve systemen naar modellen met geavanceerde cognitieve vaardigheden, die hun bruikbaarheid bij het oplossen van complexe problemen kwalitatief transformeren. De nieuwe generatie conversatiesystemen demonstreert aanzienlijk geavanceerder causaal redeneren - het vermogen om oorzakelijke verbanden te identificeren, correlatie van causaliteit te onderscheiden en robuuste mentale modellen van probleemdomeinen te construeren. Dit vermogen stelt AI-chatbots in staat om diepere analyses, nauwkeurigere voorspellingen en waardevollere data-interpretaties te bieden in vergelijking met voorgaande generaties.

Een parallelle ontwikkelingsrichting is de vooruitgang in abstract en analoog denken, waarbij modellen patronen op hoog niveau kunnen identificeren en concepten uit het ene domein kunnen toepassen op problemen in een ander domein. Dit vermogen is cruciaal voor creatieve probleemoplossing, interdisciplinaire kennisoverdracht en de identificatie van niet-voor de hand liggende verbanden, die vaak de hoogste waarde vertegenwoordigen bij complexe besluitvorming. Een belangrijke dimensie is ook de ontwikkeling van meta-cognitieve vaardigheden - het vermogen van het model om te reflecteren op zijn eigen denkprocessen, de kwaliteit van zijn antwoorden te evalueren en de grenzen van zijn eigen kennis te identificeren.

Algoritmisch redeneren en probleemoplossing in meerdere stappen

Geavanceerde architecturen tonen aanzienlijke vooruitgang in algoritmisch redeneren en probleemoplossing in meerdere stappen - het vermogen om complexe problemen te decomponeren in een reeks deelstappen, deze systematisch op te lossen en de deelresultaten te integreren in een coherente oplossing. Dit vermogen is essentieel voor taken die een gestructureerde aanpak vereisen, zoals wiskundige afleidingen, complexe planning of het debuggen van complexe systemen. In combinatie met verhoogde nauwkeurigheid (het vermogen om hallucinaties en feitelijke fouten te minimaliseren) transformeren deze geavanceerde cognitieve capaciteiten AI-chats van primair communicatiemiddelen naar geavanceerde cognitieve assistenten die substantiële ondersteuning kunnen bieden bij het oplossen van reële problemen.

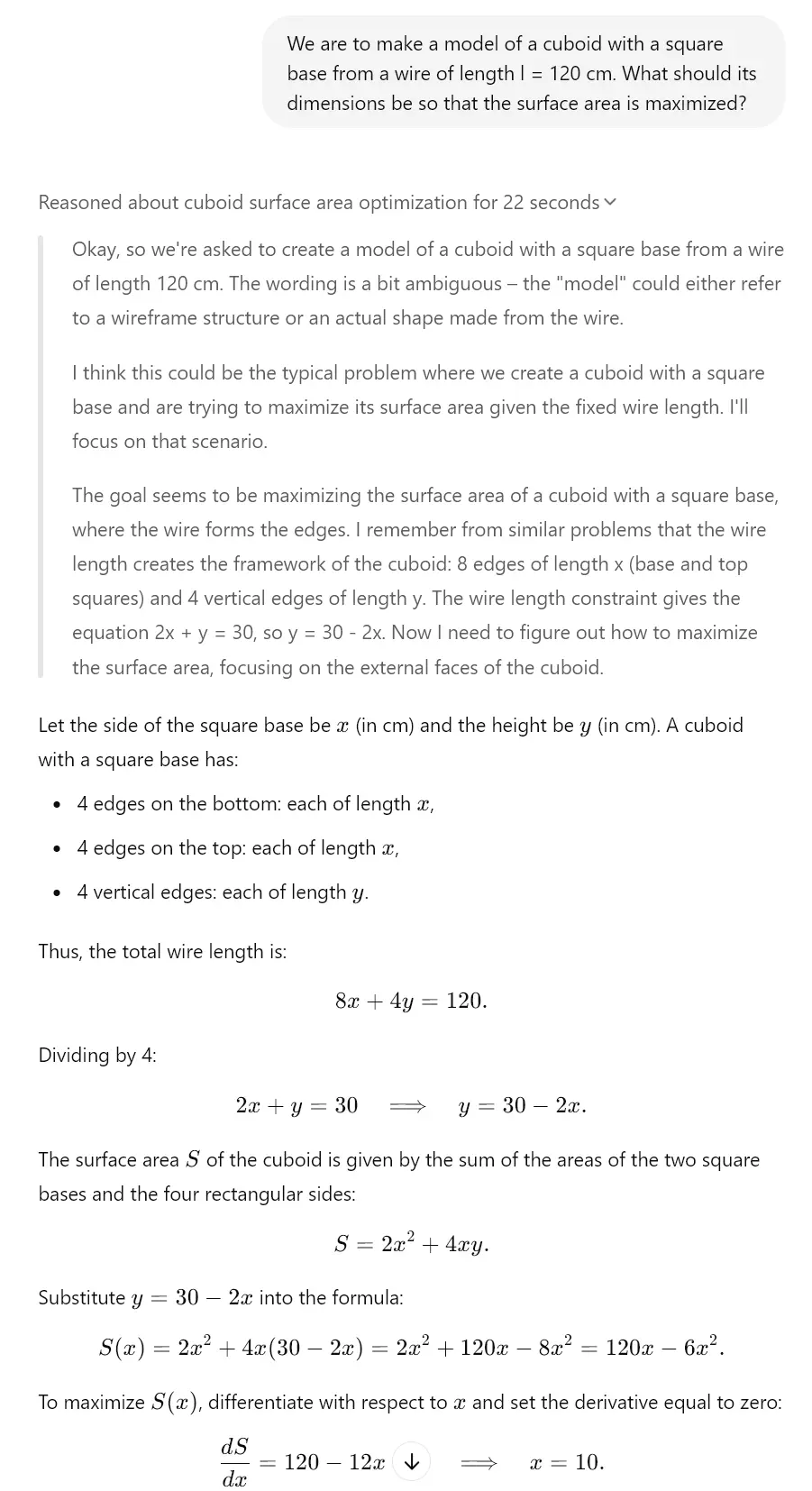

Dit is uiteindelijk al te zien bij "nadenkende" modellen van vandaag. Bijvoorbeeld Gemini 2.0, Claude 3.7 Sonnet of ChatGPT o1 hebben deze functies. Bekijk het voorbeeld dat we voor u hebben gemaakt dankzij het o3-mini-model, dat een vergelijkbaar denkmechanisme heeft.

Optimalisatie van parameters en output

Een kritiek aspect van de evolutie van AI-architecturen is de continue optimalisatie van parameters en output, wat de efficiëntie en kwaliteit van de gegenereerde inhoud verhoogt. Kwantisatietechnieken vertegenwoordigen een significante vooruitgang in modelcompressie en omvatten methoden om geheugen- en rekenvereisten te verminderen met behoud van het grootste deel van de oorspronkelijke prestaties. Moderne benaderingen zoals post-training kwantisatie en mixed-precision inferentie maken het mogelijk om de grootte van modellen tot 75% te reduceren met minimale prestatievermindering, wat het spectrum van apparaten die geavanceerde conversationele AI-systemen kunnen hosten drastisch verbreedt.

Een parallelle trend is optimalisatie door middel van kennisdestillatie, waarbij kennis van grote "leraar"-modellen wordt overgedragen naar compactere "student"-modellen. Dit proces comprimeert effectief informatie die is vastgelegd in complexe neurale netwerken tot kleinere architecturen die kunnen worden ingezet in omgevingen met beperkte middelen. Een significant potentieel ligt ook in hardware-specifieke optimalisaties, waarbij de modelarchitectuur specifiek wordt aangepast voor maximale prestaties op specifieke hardware (CPU, GPU, TPU, neuromorfe chips), wat aanzienlijk hogere inferentiesnelheden mogelijk maakt.

Adaptieve outputmechanismen

Geavanceerde architecturen implementeren adaptieve outputmechanismen, die de generatie van antwoorden dynamisch aanpassen op basis van context, nauwkeurigheidseisen en beschikbare rekenkracht. Deze systemen balanceren op intelligente wijze tussen kwaliteit, snelheid en efficiëntie door middel van technieken zoals early-exit inferentie en progressieve rendering. Het praktische gevolg van deze optimalisaties is de mogelijkheid om zeer geavanceerde AI-assistenten in te zetten, zelfs in edge computing-scenario's zoals mobiliteit, IoT-apparaten of draagbare apparaten voor augmented reality, waar traditionele grote taalmodellen onbruikbaar zijn vanwege resourcebeperkingen.

Neurale netwerken en hun ontwikkeling

Een fundamenteel aspect van de evolutie van AI-modellen is innovatie in de architectuur van neurale netwerken, die hun capaciteiten en limieten definieert. Transformationeel potentieel hebben hybride architecturen die verschillende soorten neurale netwerken combineren om hun sterke punten te maximaliseren. Deze systemen integreren op transformers gebaseerde modellen die zijn geoptimaliseerd voor tekstbegrip met convolutionele netwerken voor visuele analyse, recurrente netwerken voor sequentiële gegevens en grafische neurale netwerken voor gestructureerde informatie, waardoor veelzijdige systemen kunnen worden gecreëerd die in staat zijn om over verschillende domeinen en gegevenstypen te opereren.

Een andere ontwikkelingsrichting wordt vertegenwoordigd door recurrente transformers, die de beperkingen van standaard transformer-architecturen aanpakken op het gebied van sequentiële verwerking en temporeel redeneren. Deze modellen implementeren recurrente mechanismen zoals state tracking en iteratieve verfijning, wat hun vermogen om dynamische processen, stapsgewijs redeneren en complexe sequentiële afhankelijkheden te modelleren aanzienlijk verbetert. Dit vermogen is essentieel voor taken zoals simulatie, strategische planning of langetermijnvoorspellingen, die een geavanceerd begrip van temporele relaties vereisen.

Zelfmodificerende en zelfverbeterende architecturen

Een opkomende trend wordt vertegenwoordigd door zelfmodificerende en zelfverbeterende architecturen, die hun structuur en parameters kunnen aanpassen als reactie op specifieke taken. Deze systemen implementeren meta-learning mechanismen die continu hun interne configuratie optimaliseren op basis van feedbackloops en prestatiemetrieken. Een sleuteldimensie is ook Neural Architecture Search (NAS), waarbij AI-systemen automatisch nieuwe neurale netwerkarchitecturen ontwerpen en optimaliseren die specifiek zijn afgestemd op concrete use cases. Deze aanpak versnelt de iteratie van AI-modellen en maakt de creatie mogelijk van zeer efficiënte, op maat gemaakte architecturen voor specifieke toepassingsdomeinen van conversationele AI.

Impact van evolutie op conversationele AI

De algehele impact van de evolutie van AI-architecturen op conversatiesystemen is transformatief en brengt een fundamentele verschuiving in hun capaciteiten en toepassingspotentieel. Multimodale integratie is een sleutelelement van deze transformatie - moderne architecturen maken een naadloze overgang mogelijk tussen tekst, beeld, geluid en andere modaliteiten, waardoor de conversatie-interface verder reikt dan puur tekstuele interactie. Deze integratie stelt AI-chatbots in staat om visuele input te analyseren, te reageren op multimedia-inhoud en antwoorden te genereren met rijke media die tekst combineren met visuele of auditieve elementen. Voor een gedetailleerder inzicht in dit onderwerp kunt u kijken naar de analyse van autonome AI-agenten en multimodale systemen.

Een parallel aspect is continu leren in realtime, waarbij geavanceerde architecturen hun kennis voortdurend kunnen bijwerken en zich aanpassen aan nieuwe informatie zonder de noodzaak van volledige hertraining. Deze aanpak pakt een belangrijke beperking aan van traditionele statische modellen - de snelle veroudering van kennis in dynamisch evoluerende domeinen. Een opkomende architecturale benadering is ook lokale fine-tuning, die de prestaties van het model optimaliseert voor een specifieke context of gebruiker met behoud van de generieke capaciteiten van het basismodel.

Nieuwe generatie conversationele assistenten

Het cumulatieve effect van deze architectonische innovaties is de opkomst van een nieuwe generatie conversationele assistenten met kwalitatief verschillende capaciteiten. Deze systemen overstijgen het paradigma van reactieve vraag-en-antwoordtools en evolueren naar proactieve cognitieve partners die in staat zijn tot zelfstandig redeneren, continu leren en aanpassing aan de specifieke behoeften van gebruikers. Praktische toepassingen omvatten gepersonaliseerde onderwijssystemen die de inhoud en pedagogische aanpak dynamisch aanpassen aan de leerstijl van de student; onderzoeksassistenten die hypothesen kunnen formuleren en experimentele ontwerpen kunnen voorstellen; of strategische adviseurs die substantiële ondersteuning bieden bij complexe besluitvorming in een zakelijke context. Deze evolutie vertegenwoordigt een significante verschuiving naar AI-systemen die functioneren als echte cognitieve versterkers, die de menselijke cognitieve capaciteiten exponentieel uitbreiden.