Ewolucja architektur modeli AI i przełomowe technologie

Wydajniejsze modele architektur

Przyszłość konwersacyjnej sztucznej inteligencji jest nierozerwalnie związana z ewolucją architektur modeli AI, które przechodzą gwałtowną transformację w kierunku wyższej efektywności i wydajności. Kluczowym aspektem tej ewolucji jest technologia Mixture-of-Experts (MoE), która reprezentuje znaczący postęp od modeli monolitycznych do podejścia modułowego. Ta architektura dzieli sieć neuronową na wyspecjalizowanych „ekspertów”, którzy są aktywowani tylko dla określonych typów danych wejściowych, co dramatycznie zwiększa efektywność obliczeń.

Równoległym trendem jest implementacja mechanizmów sparse activation, które umożliwiają selektywną aktywację tylko odpowiednich części modelu dla konkretnego zadania. W przeciwieństwie do tradycyjnych architektur, gdzie aktywowane są wszystkie neurony, sparse activation dramatycznie redukuje wymagania obliczeniowe i umożliwia konstrukcję znacznie większych modeli przy zachowaniu efektywnego czasu wnioskowania. Praktyczną konsekwencją tych innowacji jest możliwość wdrażania bardziej zaawansowanych chatbotów AI nawet na urządzeniach brzegowych o ograniczonych możliwościach obliczeniowych.

Wyspecjalizowane architektury modułowe

Kolejny kierunek rozwoju stanowią wyspecjalizowane architektury modułowe, które łączą komponenty generyczne z modułami specyficznymi dla danej dziedziny. Systemy te integrują wstępnie wytrenowane podstawy generyczne z wąsko wyspecjalizowanymi modułami dla konkretnych dziedzin, takich jak medycyna, prawo czy finanse, co pozwala osiągnąć ekspercki poziom wiedzy i umiejętności bez konieczności trenowania całego modelu od podstaw. Takie podejście znacząco redukuje koszty rozwoju, a jednocześnie zwiększa dokładność i trafność odpowiedzi w konkretnych dziedzinach.

Ekspansja rozumienia kontekstu

Ewolucja architektury modeli AI zmierza w kierunku radykalnej ekspansji okna kontekstowego, co stanowi fundamentalną zmianę w zdolności do przetwarzania i spójnego reagowania na złożone dane wejściowe. Obecne ograniczenia rzędu dziesiątek czy setek tysięcy tokenów zostaną w nadchodzących generacjach modeli przezwyciężone w kierunku milionów tokenów lub potencjalnie praktycznie nieograniczonego kontekstu. Ta ekspansja umożliwi systemom konwersacyjnym utrzymywanie spójnych, długoterminowych interakcji i przetwarzanie obszernych dokumentów, takich jak całe książki, prace badawcze czy podręczniki techniczne, w jednym przebiegu.

Technologicznymi czynnikami umożliwiającymi tę transformację są hierarchiczne przetwarzanie kontekstu, gdzie model operuje na wielopoziomowych reprezentacjach – od szczegółowego poziomu lokalnego po globalne abstrakcje. Kolejnym innowacyjnym podejściem jest rekurencyjne podsumowywanie, gdzie system na bieżąco kompresuje informacje historyczne do gęstych reprezentacji, które zachowują kluczowe informacje przy minimalizacji wymagań pamięciowych. Pojawiającą się techniką jest również buforowanie uwagi (attention caching), które optymalizuje powtarzające się obliczenia na nakładających się częściach kontekstu.

Dynamiczne zarządzanie kontekstem

Zaawansowane architektury implementują dynamiczne zarządzanie kontekstem, które inteligentnie priorytetyzuje i selekcjonuje istotne informacje na podstawie ich ważności dla bieżącej konwersacji. Podejście to łączy strategie takie jak wyszukiwanie informacji, lokalna pamięć podręczna i przechowywanie pamięci długoterminowej w celu efektywnej pracy z praktycznie nieograniczoną ilością informacji kontekstowych. Praktycznym skutkiem tych innowacji jest zdolność asystentów AI do dostarczania spójnych, kontekstowo trafnych odpowiedzi nawet w ramach złożonych, wielosesyjnych interakcji trwających w dłuższym horyzoncie czasowym.

Zaawansowane zdolności poznawcze

Zasadniczym trendem w ewolucji architektur AI jest przejście od systemów czysto reaktywnych do modeli o zaawansowanych zdolnościach poznawczych, które jakościowo transformują ich użyteczność w rozwiązywaniu złożonych problemów. Nowa generacja systemów konwersacyjnych demonstruje znacznie bardziej zaawansowane rozumowanie przyczynowo-skutkowe – zdolność do identyfikowania związków przyczynowych, odróżniania korelacji od przyczynowości i konstruowania solidnych modeli mentalnych domen problemowych. Ta zdolność pozwala chatbotom AI dostarczać głębszych analiz, dokładniejszych prognoz i bardziej wartościowych interpretacji danych w porównaniu z poprzednimi generacjami.

Równoległym kierunkiem rozwoju jest postęp w myśleniu abstrakcyjnym i analogicznym, gdzie modele potrafią identyfikować wzorce wysokiego poziomu i stosować koncepcje z jednej dziedziny do problemów w innej. Ta zdolność jest kluczowa dla kreatywnego rozwiązywania problemów, interdyscyplinarnego transferu wiedzy i identyfikacji nieoczywistych powiązań, które często reprezentują najwyższą wartość przy złożonym podejmowaniu decyzji. Istotny wymiar stanowi również rozwój zdolności meta-poznawczych – zdolności modelu do refleksji nad własnymi procesami myślowymi, oceny jakości swoich odpowiedzi i identyfikacji granic własnej wiedzy.

Rozumowanie algorytmiczne i wieloetapowe rozwiązywanie problemów

Zaawansowane architektury demonstrują znaczący postęp w rozumowaniu algorytmicznym i wieloetapowym rozwiązywaniu problemów – zdolności do dekompozycji złożonych problemów na serię kroków cząstkowych, systematycznego ich rozwiązywania i integrowania częściowych wyników w spójne rozwiązanie. Ta zdolność jest niezbędna do zadań wymagających ustrukturyzowanego podejścia, takich jak wyprowadzanie wzorów matematycznych, złożone planowanie czy debugowanie skomplikowanych systemów. W połączeniu ze zwiększoną precyzją (zdolnością do minimalizowania halucynacji i błędów faktograficznych) te zaawansowane zdolności poznawcze transformują czaty AI z narzędzi głównie komunikacyjnych w zaawansowanych asystentów poznawczych zdolnych do zapewnienia merytorycznego wsparcia w rozwiązywaniu rzeczywistych problemów.

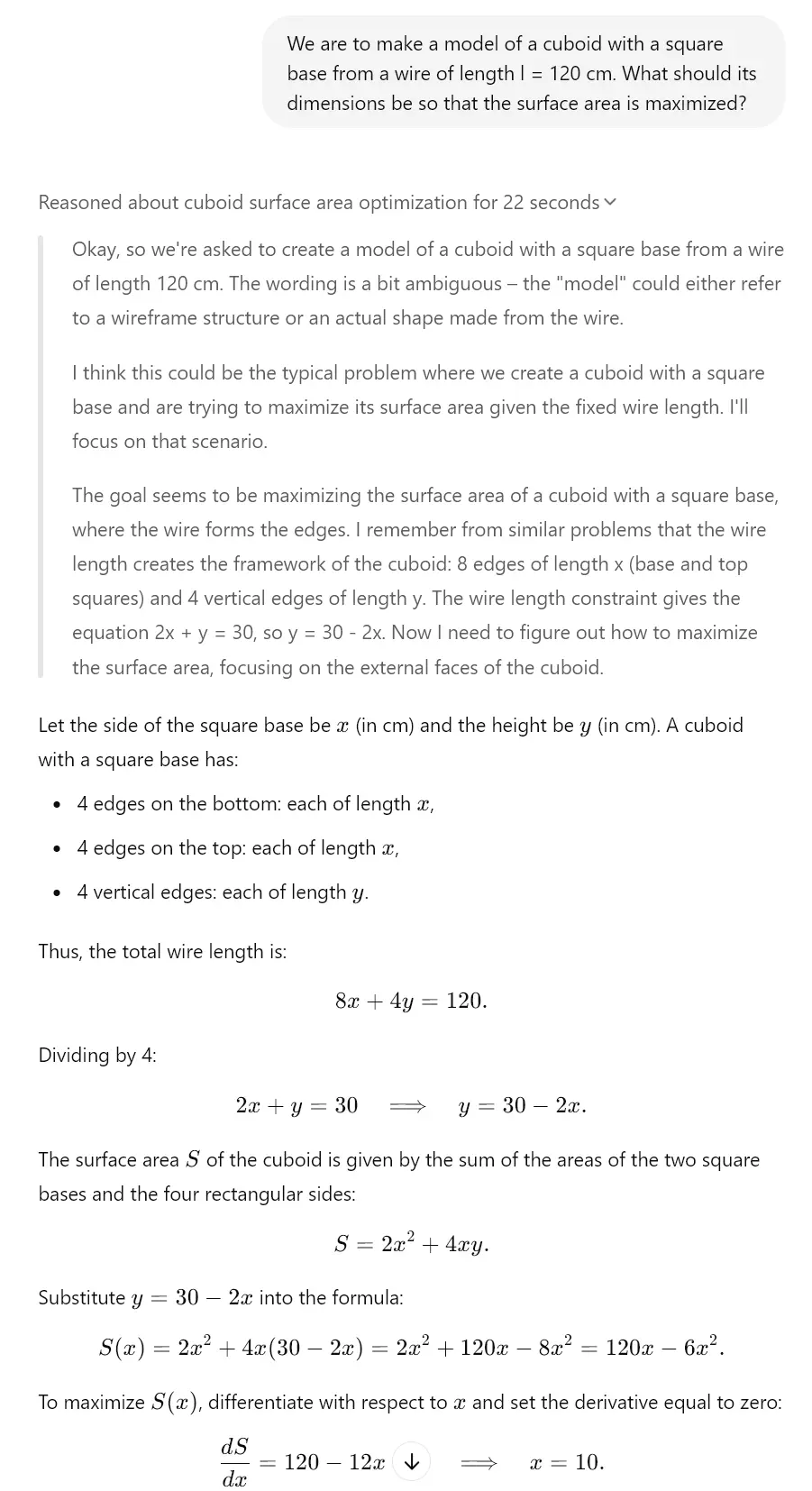

Widać to zresztą już dziś w „myślących” modelach. Na przykład Gemini 2.0, Claude 3.7 Sonnet czy ChatGPT o1 posiadają te funkcje. Spójrz na przykład, który stworzyliśmy dla Ciebie dzięki modelowi o3-mini, który ma podobny mechanizm myślenia.

Optymalizacja parametrów i wyników

Krytycznym aspektem ewolucji architektur AI jest ciągła optymalizacja parametrów i wyników, która zwiększa efektywność i jakość generowanych treści. Techniki kwantyzacji stanowią znaczący postęp w kompresji modeli i reprezentują metody redukcji zapotrzebowania na pamięć i moc obliczeniową przy zachowaniu większości pierwotnej wydajności. Nowoczesne podejścia, takie jak kwantyzacja po treningu i wnioskowanie ze zmienną precyzją, umożliwiają redukcję rozmiaru modeli nawet o 75% przy minimalnej degradacji wydajności, co dramatycznie rozszerza spektrum urządzeń zdolnych do hostowania zaawansowanych systemów konwersacyjnej AI.

Równoległym trendem jest optymalizacja poprzez destylację wiedzy, gdzie wiedza z dużych modeli „nauczycielskich” jest przenoszona do bardziej kompaktowych modeli „uczniowskich”. Proces ten efektywnie kompresuje informacje zawarte w złożonych sieciach neuronowych do mniejszych architektur, które mogą być wdrażane w środowiskach o ograniczonych zasobach. Znaczący potencjał stanowią również optymalizacje specyficzne dla sprzętu, gdzie architektura modelu jest specjalnie dostosowywana do maksymalnej wydajności na konkretnym sprzęcie (CPU, GPU, TPU, chipy neuromorficzne), co pozwala osiągnąć znacznie wyższą szybkość wnioskowania.

Adaptacyjne mechanizmy wyjściowe

Zaawansowane architektury implementują adaptacyjne mechanizmy wyjściowe, które dynamicznie dostosowują generowanie odpowiedzi na podstawie kontekstu, wymagań dotyczących dokładności i dostępnych zasobów obliczeniowych. Systemy te inteligentnie balansują między jakością, szybkością i efektywnością za pomocą technik takich jak wnioskowanie z wczesnym zakończeniem i progresywne renderowanie. Praktyczną konsekwencją tych optymalizacji jest możliwość wdrażania wysoce zaawansowanych asystentów AI nawet w scenariuszach edge computing, takich jak mobilność, urządzenia IoT czy urządzenia noszone do rzeczywistości rozszerzonej, gdzie tradycyjne duże modele językowe są nieużyteczne ze względu na ograniczenia zasobów.

Sieci neuronowe i ich rozwój

Fundamentalnym aspektem ewolucji modeli AI jest innowacja w architekturze sieci neuronowych, która definiuje ich możliwości i ograniczenia. Potencjał transformacyjny mają architektury hybrydowe łączące różne typy sieci neuronowych w celu maksymalizacji ich mocnych stron. Systemy te integrują modele oparte na transformerach zoptymalizowane pod kątem rozumienia tekstu z sieciami konwolucyjnymi do analizy wizualnej, sieciami rekurencyjnymi dla danych sekwencyjnych i grafowymi sieciami neuronowymi dla informacji strukturalnych, co pozwala na tworzenie wszechstronnych systemów zdolnych do operowania w różnych dziedzinach i typach danych.

Kolejny kierunek rozwoju stanowią rekurencyjne transformery, które adresują ograniczenia standardowych architektur transformerów w zakresie przetwarzania sekwencyjnego i rozumowania czasowego. Modele te implementują mechanizmy rekurencyjne, takie jak śledzenie stanu i iteracyjne udoskonalanie, co znacząco poprawia ich zdolność do modelowania dynamicznych procesów, stopniowego rozumowania i złożonych zależności sekwencyjnych. Ta zdolność jest niezbędna do zadań takich jak symulacje, planowanie strategiczne czy długoterminowe prognozy, które wymagają zaawansowanego rozumienia relacji czasowych.

Architektury samomodyfikujące się i samodoskonalące

Pojawiającym się trendem są architektury samomodyfikujące się i samodoskonalące, które potrafią adaptować swoją strukturę i parametry w odpowiedzi na specyficzne zadania. Systemy te implementują mechanizmy meta-uczenia, które ciągle optymalizują ich wewnętrzną konfigurację na podstawie pętli sprzężenia zwrotnego i metryk wydajności. Kluczowy wymiar stanowi również wyszukiwanie architektur neuronowych (NAS), gdzie systemy AI automatycznie projektują i optymalizują nowe architektury sieci neuronowych specjalnie dostosowane do konkretnych przypadków użycia. Takie podejście przyspiesza iterację modeli AI i umożliwia tworzenie wysoce efektywnych, niestandardowych architektur dla specyficznych domen aplikacji konwersacyjnej AI.

Wpływ ewolucji na konwersacyjną AI

Całkowity wpływ ewolucji architektur AI na systemy konwersacyjne jest transformacyjny, przynosząc fundamentalną zmianę w ich możliwościach i potencjale aplikacyjnym. Integracja multimodalna stanowi kluczowy element tej transformacji – nowoczesne architektury umożliwiają płynne przechodzenie między tekstem, obrazem, dźwiękiem i innymi modalnościami, co rozszerza interfejsy konwersacyjne poza granice czysto tekstowej interakcji. Ta integracja pozwala chatbotom AI analizować dane wizualne, reagować na treści multimedialne i generować odpowiedzi z bogatymi mediami łączącymi tekst z elementami wizualnymi lub dźwiękowymi. Aby uzyskać bardziej szczegółowy wgląd w tę problematykę, można zapoznać się z analizą autonomicznych agentów AI i systemów multimodalnych.

Równoległym aspektem jest ciągłe uczenie się w czasie rzeczywistym, gdzie zaawansowane architektury potrafią na bieżąco aktualizować swoją wiedzę i adaptować się do nowych informacji bez konieczności całkowitego ponownego trenowania. Takie podejście adresuje kluczowe ograniczenie tradycyjnych modeli statycznych – szybką dezaktualizację wiedzy w dynamicznie rozwijających się dziedzinach. Pojawiającym się podejściem architektonicznym jest również lokalne dostrajanie, które optymalizuje wydajność modelu dla specyficznego kontekstu lub użytkownika przy zachowaniu generycznych zdolności podstawowego modelu.

Nowa generacja asystentów konwersacyjnych

Skumulowanym efektem tych innowacji architektonicznych jest pojawienie się nowej generacji asystentów konwersacyjnych o jakościowo odmiennych zdolnościach. Systemy te przekraczają paradygmat reaktywnych narzędzi do zadawania pytań i odpowiedzi w kierunku proaktywnych partnerów poznawczych zdolnych do samodzielnego rozumowania, ciągłego uczenia się i adaptacji do specyficznych potrzeb użytkowników. Praktyczne zastosowania obejmują spersonalizowane systemy edukacyjne dynamicznie dostosowujące treść i podejście pedagogiczne do stylu uczenia się studenta; asystentów badawczych zdolnych do formułowania hipotez i projektowania eksperymentów; lub doradców strategicznych zapewniających merytoryczne wsparcie przy złożonym podejmowaniu decyzji w kontekście biznesowym. Ta ewolucja reprezentuje znaczący postęp w kierunku systemów AI, które funkcjonują jako prawdziwe wzmacniacze poznawcze, eksponencjalnie rozszerzając ludzkie zdolności poznawcze.