Evolução das arquiteturas de modelos de IA e tecnologias disruptivas

Modelos de arquitetura mais eficientes

O futuro da inteligência artificial conversacional está intrinsecamente ligado à evolução das arquiteturas de modelos de IA, que estão passando por uma rápida transformação em direção a maior eficiência e desempenho. Um aspeto chave desta evolução é a tecnologia Mixture-of-Experts (MoE), que representa uma mudança significativa de modelos monolíticos para uma abordagem modular. Esta arquitetura divide a rede neural em "especialistas" especializados, que são ativados apenas para tipos específicos de entradas, aumentando drasticamente a eficiência computacional.

Uma tendência paralela é a implementação de mecanismos de ativação esparsa (sparse activation), que permitem a ativação seletiva apenas das partes relevantes do modelo para uma tarefa específica. Ao contrário das arquiteturas tradicionais, onde todos os neurônios são ativados, a ativação esparsa reduz drasticamente os requisitos computacionais e permite a construção de modelos significativamente maiores, mantendo um tempo de inferência eficiente. A consequência prática dessas inovações é a possibilidade de implantar chatbots de IA mais sofisticados, mesmo em dispositivos de ponta com capacidades computacionais limitadas.

Arquiteturas modulares especializadas

Outra direção de desenvolvimento são as arquiteturas modulares especializadas, que combinam componentes genéricos com módulos específicos de domínio. Estes sistemas integram bases genéricas pré-treinadas com módulos altamente especializados para domínios específicos como medicina, direito ou finanças, permitindo alcançar um nível de conhecimento e capacidades de especialista sem a necessidade de treinar todo o modelo do zero. Esta abordagem reduz significativamente os custos de desenvolvimento e, ao mesmo tempo, aumenta a precisão e a relevância das respostas em áreas específicas.

Expansão da compreensão contextual

A evolução da arquitetura de modelos de IA está caminhando para uma expansão radical da janela de contexto, o que representa uma mudança fundamental na capacidade de processar e responder coerentemente a entradas complexas. As limitações atuais na ordem de dezenas ou centenas de milhares de tokens serão superadas nas próximas gerações de modelos, caminhando para milhões de tokens ou potencialmente para um contexto praticamente ilimitado. Essa expansão permitirá que os sistemas conversacionais mantenham interações consistentes de longo prazo e processem documentos extensos como livros completos, trabalhos de pesquisa ou manuais técnicos em uma única passagem.

Os facilitadores tecnológicos desta transformação incluem o processamento hierárquico de contexto, onde o modelo opera com representações multinível - desde o nível local detalhado até abstrações globais. Outra abordagem inovadora é a sumarização recursiva, onde o sistema comprime continuamente informações históricas em representações densas que preservam informações chave enquanto minimizam os requisitos de memória. Uma técnica emergente é também o cache de atenção (attention caching), que otimiza cálculos repetidos em partes sobrepostas do contexto.

Gerenciamento dinâmico de contexto

Arquiteturas avançadas implementam o gerenciamento dinâmico de contexto, que prioriza e seleciona inteligentemente informações relevantes com base em sua importância para a conversa atual. Esta abordagem combina estratégias como recuperação de informações, cache local e armazenamento de memória de longo prazo para trabalhar eficientemente com uma quantidade praticamente ilimitada de informações contextuais. O impacto prático dessas inovações é a capacidade dos assistentes de IA de fornecer respostas consistentes e contextualmente relevantes, mesmo em interações complexas de várias sessões que ocorrem ao longo de um período de tempo mais longo.

Capacidades cognitivas avançadas

Uma tendência fundamental na evolução das arquiteturas de IA é a mudança de sistemas puramente reativos para modelos com capacidades cognitivas avançadas, que transformam qualitativamente sua utilidade na resolução de problemas complexos. A nova geração de sistemas conversacionais demonstra um raciocínio causal significativamente mais sofisticado - a capacidade de identificar relações causais, distinguir correlação de causalidade e construir modelos mentais robustos de domínios problemáticos. Essa capacidade permite que os chatbots de IA forneçam análises mais profundas, previsões mais precisas e interpretações de dados mais valiosas em comparação com as gerações anteriores.

Uma direção de desenvolvimento paralela é o progresso no pensamento abstrato e analógico, onde os modelos podem identificar padrões de alto nível e aplicar conceitos de um domínio a problemas em outro domínio. Essa capacidade é crucial para a resolução criativa de problemas, transferência interdisciplinar de conhecimento e identificação de conexões não óbvias, que muitas vezes representam o maior valor na tomada de decisões complexas. Uma dimensão importante é também o desenvolvimento de capacidades metacognitivas - a capacidade do modelo de refletir sobre seus próprios processos de pensamento, avaliar a qualidade de suas respostas e identificar os limites de seu próprio conhecimento.

Raciocínio algorítmico e resolução de problemas em várias etapas

Arquiteturas avançadas demonstram um progresso significativo no raciocínio algorítmico e na resolução de problemas em várias etapas - a capacidade de decompor problemas complexos em uma série de etapas parciais, resolvê-los sistematicamente e integrar resultados parciais em uma solução coerente. Essa capacidade é essencial para tarefas que exigem uma abordagem estruturada, como derivações matemáticas, planejamento complexo ou depuração de sistemas complexos. Em combinação com maior precisão (a capacidade de minimizar alucinações e erros factuais), essas capacidades cognitivas avançadas transformam os chats de IA de ferramentas primariamente de comunicação em assistentes cognitivos sofisticados capazes de fornecer suporte substancial na resolução de problemas reais.

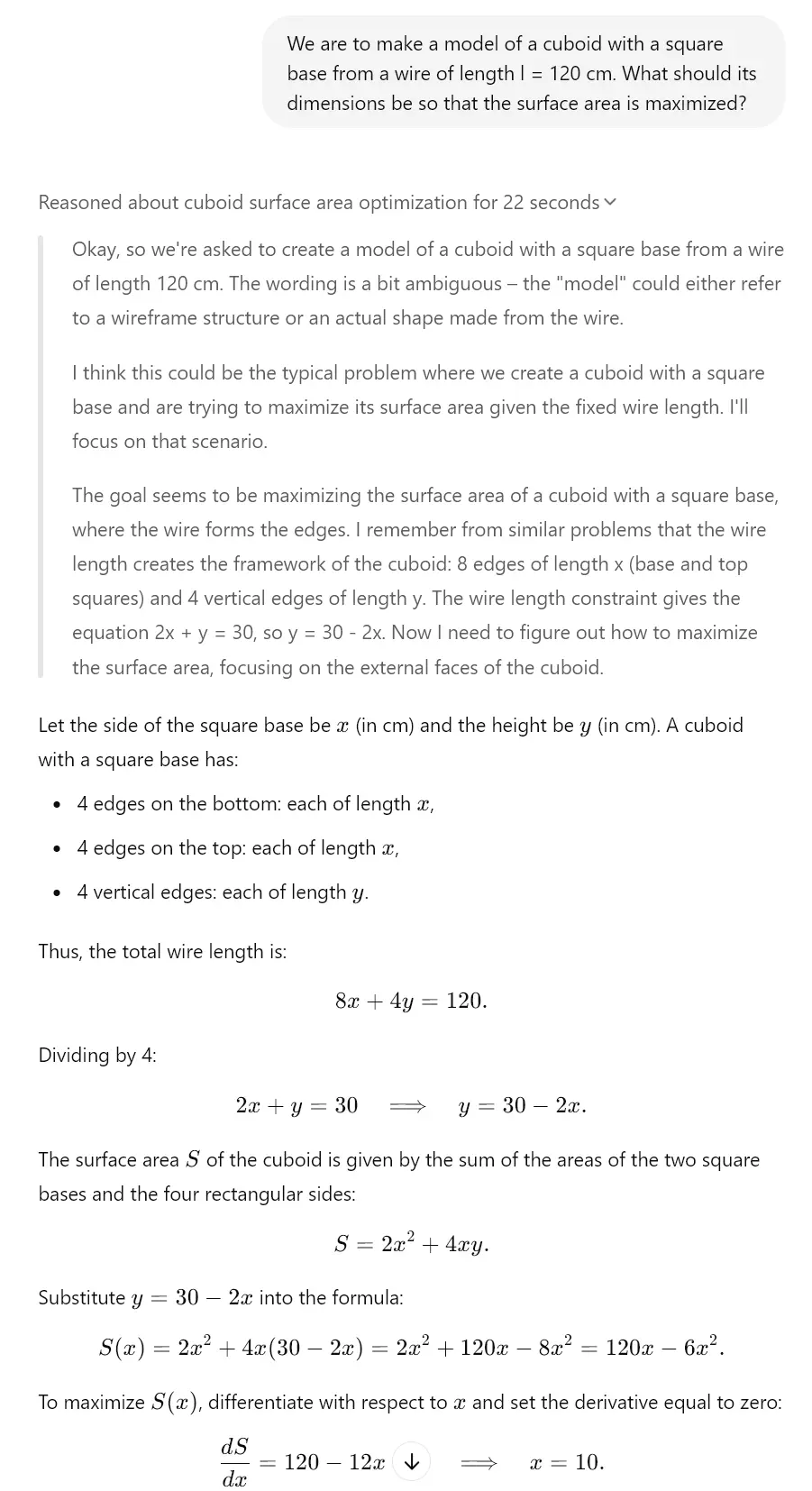

Isso é, afinal, visível nos modelos "reflexivos" já hoje. Por exemplo, Gemini 2.0, Claude 3.7 Sonnet ou ChatGPT o1 têm essas funções. Veja o exemplo que criamos para você graças ao modelo o3-mini, que possui um mecanismo reflexivo semelhante.

Otimização de parâmetros e saídas

Um aspeto crítico da evolução das arquiteturas de IA é a otimização contínua de parâmetros e saídas, que aumenta a eficiência e a qualidade do conteúdo gerado. As técnicas de quantização representam um avanço significativo na compressão de modelos e são métodos para reduzir os requisitos de memória e computacionais, mantendo a maior parte do desempenho original. Abordagens modernas como quantização pós-treinamento e inferência com precisão mista permitem reduzir o tamanho dos modelos em até 75% com degradação mínima de desempenho, o que expande dramaticamente o espectro de dispositivos capazes de hospedar sistemas sofisticados de IA conversacional.

Uma tendência paralela é a otimização através da destilação de conhecimento, onde o conhecimento de grandes modelos "professores" é transferido para modelos "alunos" mais compactos. Este processo comprime eficientemente as informações capturadas em redes neurais complexas em arquiteturas menores que podem ser implantadas em ambientes com recursos limitados. Um potencial significativo também é representado por otimizações específicas de hardware, onde a arquitetura do modelo é especificamente ajustada para desempenho máximo em hardware específico (CPU, GPU, TPU, chips neuromórficos), permitindo alcançar velocidades de inferência significativamente mais altas.

Mecanismos de saída adaptativos

Arquiteturas avançadas implementam mecanismos de saída adaptativos que ajustam dinamicamente a geração de respostas com base no contexto, requisitos de precisão e recursos computacionais disponíveis. Esses sistemas equilibram inteligentemente entre qualidade, velocidade e eficiência através de técnicas como inferência com terminação antecipada e renderização progressiva. A consequência prática dessas otimizações é a capacidade de implantar assistentes de IA altamente sofisticados mesmo em cenários de edge computing como mobilidade, dispositivos IoT ou dispositivos vestíveis para realidade aumentada, onde os modelos de linguagem grandes tradicionais são inutilizáveis devido a limitações de recursos.

Redes neurais e seu desenvolvimento

Um aspeto fundamental da evolução dos modelos de IA são as inovações na arquitetura das redes neurais, que definem suas capacidades e limites. As arquiteturas híbridas, que combinam diferentes tipos de redes neurais para maximizar seus pontos fortes, têm um potencial transformador. Estes sistemas integram modelos baseados em transformadores otimizados para compreensão de texto com redes convolucionais para análise visual, redes recorrentes para dados sequenciais e redes neurais de grafos para informações estruturadas, permitindo a criação de sistemas versáteis capazes de operar em diferentes domínios e tipos de dados.

Outra direção de desenvolvimento são os transformadores recorrentes, que abordam as limitações das arquiteturas de transformadores padrão na área de processamento sequencial e raciocínio temporal. Esses modelos implementam mecanismos recorrentes como rastreamento de estado e refinamento iterativo, o que melhora significativamente sua capacidade de modelar processos dinâmicos, raciocínio gradual e dependências sequenciais complexas. Essa capacidade é essencial para tarefas como simulação, planejamento estratégico ou previsões de longo prazo, que exigem uma compreensão sofisticada das relações temporais.

Arquiteturas automodificáveis e autoaperfeiçoadoras

Uma tendência emergente são as arquiteturas automodificáveis e autoaperfeiçoadoras, que podem adaptar sua estrutura e parâmetros em resposta a tarefas específicas. Esses sistemas implementam mecanismos de meta-aprendizagem que otimizam continuamente sua configuração interna com base em loops de feedback e métricas de desempenho. Uma dimensão chave é também a busca de arquitetura neural (NAS - Neural Architecture Search), onde sistemas de IA projetam e otimizam automaticamente novas arquiteturas de redes neurais especificamente adaptadas a casos de uso específicos. Essa abordagem acelera a iteração de modelos de IA e permite a criação de arquiteturas personalizadas altamente eficientes para domínios de aplicação específicos da IA conversacional.

Impacto da evolução na IA conversacional

O impacto geral da evolução das arquiteturas de IA nos sistemas conversacionais é transformador, trazendo uma mudança fundamental em suas capacidades e potencial de aplicação. A integração multimodal representa um elemento chave desta transformação - arquiteturas modernas permitem uma transição suave entre texto, imagem, som e outras modalidades, o que expande as interfaces conversacionais para além da interação puramente textual. Essa integração permite que os chatbots de IA analisem entradas visuais, respondam a conteúdo multimídia e gerem respostas com mídias ricas combinando texto com elementos visuais ou auditivos. Para uma visão mais detalhada sobre este tópico, você pode consultar a análise de agentes de IA autônomos e sistemas multimodais.

Um aspeto paralelo é o aprendizado contínuo em tempo real, onde arquiteturas avançadas podem atualizar continuamente seus conhecimentos e adaptar-se a novas informações sem a necessidade de um retreinamento completo. Essa abordagem aborda uma limitação chave dos modelos estáticos tradicionais - a rápida obsolescência do conhecimento em domínios em desenvolvimento dinâmico. Uma abordagem arquitetônica emergente é também o ajuste fino local (local fine-tuning), que otimiza o desempenho do modelo para um contexto ou usuário específico, mantendo as capacidades genéricas do modelo base.

Nova geração de assistentes conversacionais

O efeito cumulativo dessas inovações arquitetônicas é o surgimento de uma nova geração de assistentes conversacionais com capacidades qualitativamente diferentes. Esses sistemas transcendem o paradigma de ferramentas reativas de perguntas e respostas em direção a parceiros cognitivos proativos capazes de raciocínio independente, aprendizado contínuo e adaptação às necessidades específicas dos usuários. Aplicações práticas incluem sistemas educacionais personalizados que adaptam dinamicamente o conteúdo e a abordagem pedagógica ao estilo de aprendizagem do aluno; assistentes de pesquisa capazes de formular hipóteses e propor desenhos experimentais; ou consultores estratégicos que fornecem suporte substancial na tomada de decisões complexas em um contexto de negócios. Essa evolução representa uma mudança significativa em direção a sistemas de IA que funcionam como verdadeiros amplificadores cognitivos, expandindo exponencialmente as capacidades cognitivas humanas.