Utvecklingen av AI-modellarkitekturer och banbrytande teknologier

Effektivare modellarkitekturer

Framtiden för konversations-AI är oupplösligt kopplad till utvecklingen av AI-modellarkitekturer, som genomgår en snabb transformation mot högre effektivitet och prestanda. En nyckelaspekt i denna utveckling är teknologin Mixture-of-Experts (MoE), som representerar ett betydande skifte från monolitiska modeller till ett modulärt tillvägagångssätt. Denna arkitektur delar upp det neurala nätverket i specialiserade "experter" som aktiveras endast för specifika typer av indata, vilket dramatiskt ökar beräkningseffektiviteten.

En parallell trend är implementeringen av mekanismer för sparse activation (gles aktivering), som möjliggör selektiv aktivering av endast relevanta delar av modellen för en specifik uppgift. Till skillnad från traditionella arkitekturer, där alla neuroner aktiveras, minskar gles aktivering dramatiskt beräknings- kraven och möjliggör konstruktion av betydligt större modeller samtidigt som en effektiv inferenstid bibehålls. Den praktiska konsekvensen av dessa innovationer är möjligheten att distribuera mer sofistikerade AI-chattbotar även på edge-enheter med begränsade beräkningskapaciteter.

Specialiserade modulära arkitekturer

En annan utvecklingsriktning representeras av specialiserade modulära arkitekturer, som kombinerar generiska komponenter med domänspecifika moduler. Dessa system integrerar förtränade generiska grunder med snävt specialiserade moduler för specifika domäner som medicin, juridik eller finans, vilket gör det möjligt att uppnå expertnivå av kunskap och förmågor utan att behöva träna hela modellen från grunden. Detta tillvägagångssätt minskar signifikant utvecklingskostnaderna och samtidigt ökar precisionen och relevansen av svaren inom specifika områden.

Expansion av kontextuell förståelse

Utvecklingen av AI-modellarkitekturer går mot en radikal expansion av kontextfönstret, vilket representerar ett fundamentalt skifte i förmågan att bearbeta och koherent reagera på komplexa indata. Nuvarande begränsningar på tiotusentals eller hundratusentals tokens kommer att övervinnas i kommande generationer av modeller mot miljontals tokens eller potentiellt praktiskt taget obegränsad kontext. Denna expansion kommer att göra det möjligt för konversationssystem att upprätthålla konsekventa långsiktiga interaktioner och bearbeta omfattande dokument som kompletta böcker, forskningsartiklar eller tekniska manualer i en enda genomgång.

Teknologiska möjliggörare för denna transformation inkluderar hierarkisk kontextbearbetning, där modellen opererar med representationer på flera nivåer - från detaljerad lokal nivå till globala abstraktioner. Ett annat innovativt tillvägagångssätt är rekursiv sammanfattning, där systemet kontinuerligt komprimerar historisk information till täta representationer som bevarar nyckelinformation samtidigt som minneskraven minimeras. En framväxande teknik är också attention caching (uppmärksamhetscachning), som optimerar upprepade beräkningar på överlappande delar av kontexten.

Dynamisk kontexthantering

Avancerade arkitekturer implementerar dynamisk kontexthantering, som intelligent prioriterar och väljer relevant information baserat på dess betydelse för den aktuella konversationen. Detta tillvägagångssätt kombinerar strategier som informationssökning, lokal cache och lagring av långtidsminne för effektivt arbete med praktiskt taget obegränsade mängder kontextuell information. Den praktiska effekten av dessa innovationer är AI-assistenters förmåga att tillhandahålla konsekventa, kontextuellt relevanta svar även inom komplexa, multi-session interaktioner som pågår över en längre tidsperiod.

Avancerade kognitiva förmågor

En grundläggande trend i utvecklingen av AI-arkitekturer är skiftet från rent reaktiva system till modeller med avancerade kognitiva förmågor, vilket kvalitativt transformerar deras användbarhet vid lösning av komplexa problem. Den nya generationen av konversationssystem demonstrerar betydligt mer sofistikerat kausalt resonemang - förmågan att identifiera orsakssamband, skilja korrelation från kausalitet och konstruera robusta mentala modeller av problemdomäner. Denna förmåga gör det möjligt för AI-chattbotar att tillhandahålla djupare analyser, mer exakta prediktioner och mer värdefulla tolkningar av data jämfört med tidigare generationer.

En parallell utvecklingsriktning är framsteg inom abstrakt och analogt tänkande, där modeller kan identifiera mönster på hög nivå och tillämpa koncept från en domän på problem i en annan domän. Denna förmåga är avgörande för kreativ problemlösning, tvärvetenskaplig kunskapsöverföring och identifiering av icke-uppenbara samband, som ofta representerar det högsta värdet vid komplext beslutsfattande. En viktig dimension representeras också av utvecklingen av metakognitiva förmågor - modellens förmåga att reflektera över sina egna tankeprocesser, utvärdera kvaliteten på sina svar och identifiera gränserna för sin egen kunskap.

Algoritmiskt resonemang och problemlösning i flera steg

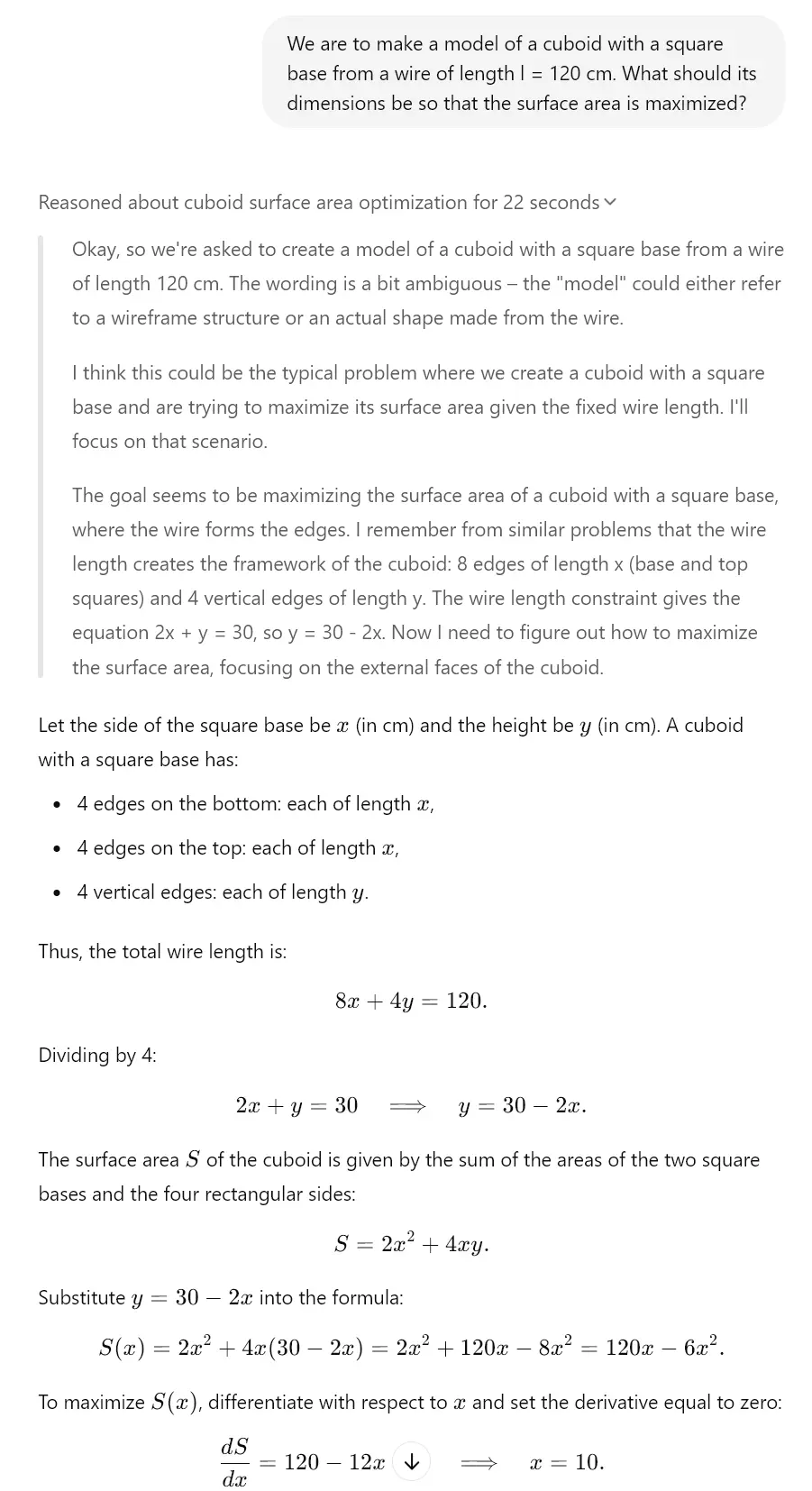

Avancerade arkitekturer demonstrerar betydande framsteg inom algoritmiskt resonemang och problemlösning i flera steg - förmågan att dekomponera komplexa problem i en serie delsteg, systematiskt lösa dem och integrera delresultat i en koherent lösning. Denna förmåga är essentiell för uppgifter som kräver ett strukturerat tillvägagångssätt som matematiska derivationer, komplex planering eller felsökning av komplexa system. I kombination med ökad precision (förmågan att minimera hallucinationer och faktafel) transformerar dessa avancerade kognitiva kapaciteter AI-chattar från primärt kommunikationsverktyg till sofistikerade kognitiva assistenter kapabla att ge substantiellt stöd vid lösning av verkliga problem.

Detta syns trots allt redan idag hos "tänkande" modeller. Till exempel har Gemini 2.0, Claude 3.7 Sonnet eller ChatGPT o1 dessa funktioner. Titta på exemplet som vi skapade åt dig tack vare o3-mini-modellen, som har en liknande tänkande mekanism.

Optimering av parametrar och utdata

En kritisk aspekt av utvecklingen av AI-arkitekturer är den kontinuerliga optimeringen av parametrar och utdata, vilket ökar effektiviteten och kvaliteten på det genererade innehållet. Kvantiseringstekniker representerar ett betydande framsteg inom modellkomprimering och representerar metoder för att minska minnes- och beräkningskraven samtidigt som större delen av den ursprungliga prestandan bibehålls. Moderna tillvägagångssätt som post-training kvantisering och inferens med blandad precision gör det möjligt att minska modellstorleken med upp till 75% med minimal prestandaförsämring, vilket dramatiskt utökar spektrumet av enheter som kan köra sofistikerade konversations-AI-system.

En parallell trend är optimering genom kunskapsdestillation, där kunskap från stora "lärar"-modeller överförs till mer kompakta "student"-modeller. Denna process komprimerar effektivt information som fångats i komplexa neurala nätverk till mindre arkitekturer, som kan distribueras i miljöer med begränsade resurser. Betydande potential representeras också av hårdvaruspecifika optimeringar, där modellarkitekturen specifikt anpassas för maximal prestanda på specifik hårdvara (CPU, GPU, TPU, neuromorfiska chip), vilket gör det möjligt att uppnå betydligt högre inferenshastighet.

Adaptiva utdatamekanismer

Avancerade arkitekturer implementerar adaptiva utdatamekanismer, som dynamiskt anpassar genereringen av svar baserat på kontext, krav på precision och tillgängliga beräkningsresurser. Dessa system balanserar intelligent mellan kvalitet, hastighet och effektivitet genom tekniker som inferens med tidigt avslut och progressiv rendering. Den praktiska konsekvensen av dessa optimeringar är förmågan att distribuera högst sofistikerade AI-assistenter även i scenarier för edge computing som mobilitet, IoT-enheter eller bärbara enheter för förstärkt verklighet, där traditionella stora språkmodeller är oanvändbara på grund av resursbegränsningar.

Neurala nätverk och deras utveckling

En fundamental aspekt av utvecklingen av AI-modeller representeras av innovationer inom arkitekturen för neurala nätverk, som definierar deras förmågor och begränsningar. Transformerande potential har hybridarkitekturer som kombinerar olika typer av neurala nätverk för att maximera deras styrkor. Dessa system integrerar modeller baserade på transformatorer optimerade för textförståelse med konvolutionella nätverk för visuell analys, rekurrenta nätverk för sekventiell data och grafneurala nätverk för strukturerad information, vilket möjliggör skapandet av mångsidiga system kapabla att operera över olika domäner och datatyper.

En annan utvecklingsriktning representeras av rekurrenta transformatorer, som adresserar begränsningarna hos standard transformer-arkitekturer inom området sekventiell bearbetning och temporalt resonemang. Dessa modeller implementerar rekurrenta mekanismer som tillståndsspårning och iterativ förbättring, vilket signifikant förbättrar deras förmåga att modellera dynamiska processer, stegvist resonemang och komplexa sekventiella beroenden. Denna förmåga är essentiell för uppgifter som simulering, strategisk planering eller långsiktiga prediktioner, som kräver sofistikerad förståelse av temporala relationer.

Självmodifierande och självförbättrande arkitekturer

En framväxande trend representeras av självmodifierande och självförbättrande arkitekturer, som kan anpassa sin struktur och sina parametrar som svar på specifika uppgifter. Dessa system implementerar mekanismer för meta-inlärning, som kontinuerligt optimerar deras interna konfiguration baserat på återkopplingsslingor och prestandamått. En nyckeldimension representeras också av Neural Architecture Search (NAS), där AI-system automatiskt designar och optimerar nya arkitekturer för neurala nätverk specifikt anpassade för konkreta användningsfall. Detta tillvägagångssätt påskyndar iterationen av AI-modeller och möjliggör skapandet av högeffektiva anpassade arkitekturer för specifika applikationsdomäner inom konversations-AI.

Evolutionens inverkan på konversations-AI

Den samlade inverkan av utvecklingen av AI-arkitekturer på konversationssystem är transformativ och medför ett fundamentalt skifte i deras förmågor och applikations- potential. Multimodal integration representerar ett nyckelelement i denna transformation - moderna arkitekturer möjliggör en smidig övergång mellan text, bild, ljud och andra modaliteter, vilket utvidgar konversationsgränssnittet bortom gränserna för rent textbaserad interaktion. Denna integration gör det möjligt för AI-chattbotar att analysera visuella indata, reagera på multimediainnehåll och generera svar med rika medier som kombinerar text med visuella eller auditiva element. För en mer detaljerad titt på denna problematik kan du se analys av autonoma AI-agenter och multimodala system.

En parallell aspekt är kontinuerlig inlärning i realtid, där avancerade arkitekturer kan kontinuerligt uppdatera sin kunskap och anpassa sig till ny information utan behov av fullständig omträning. Detta tillvägagångssätt adresserar en nyckelbegränsning hos traditionella statiska modeller - den snabba föråldringen av kunskap i dynamiskt utvecklande domäner. Ett framväxande arkitektoniskt tillvägagångssätt representerar också lokal finjustering, som optimerar modellens prestanda för en specifik kontext eller användare samtidigt som de generiska förmågorna hos grundmodellen bibehålls.

Ny generation av konversationsassistenter

Den kumulativa effekten av dessa arkitektoniska innovationer är framväxten av en ny generation konversationsassistenter med kvalitativt annorlunda förmågor. Dessa system överskrider paradigmet med reaktiva verktyg för frågor och svar mot proaktiva kognitiva partners kapabla till självständigt resonemang, kontinuerlig inlärning och anpassning till specifika användarbehov. Praktiska tillämpningar inkluderar personaliserade utbildningssystem som dynamiskt anpassar innehåll och pedagogiskt tillvägagångssätt till studentens inlärningsstil; forskningsassistenter kapabla att formulera hypoteser och föreslå experimentell design; eller strategiska rådgivare som tillhandahåller substantiellt stöd vid komplext beslutsfattande i affärskontext. Denna utveckling representerar ett signifikant skifte mot AI-system som fungerar som verkliga kognitiva förstärkare som exponentiellt utökar mänskliga kognitiva kapaciteter.